LLMOps: porta els teus models d'IA a producció real

MLflow · LangSmith · Kubernetes · Guardrails

El 87% dels projectes de ML mai arriben a producció. LLMOps és la disciplina que tanca aquesta bretxa: desplegament, monitorització, avaluació i escalat de models de llenguatge amb rigor d'enginyeria.

Què inclou el nostre servei LLMOps

Tot el que necessites per operar LLMs amb garanties.

Observabilitat d'IA en temps real

No pots millorar el que no mesures.

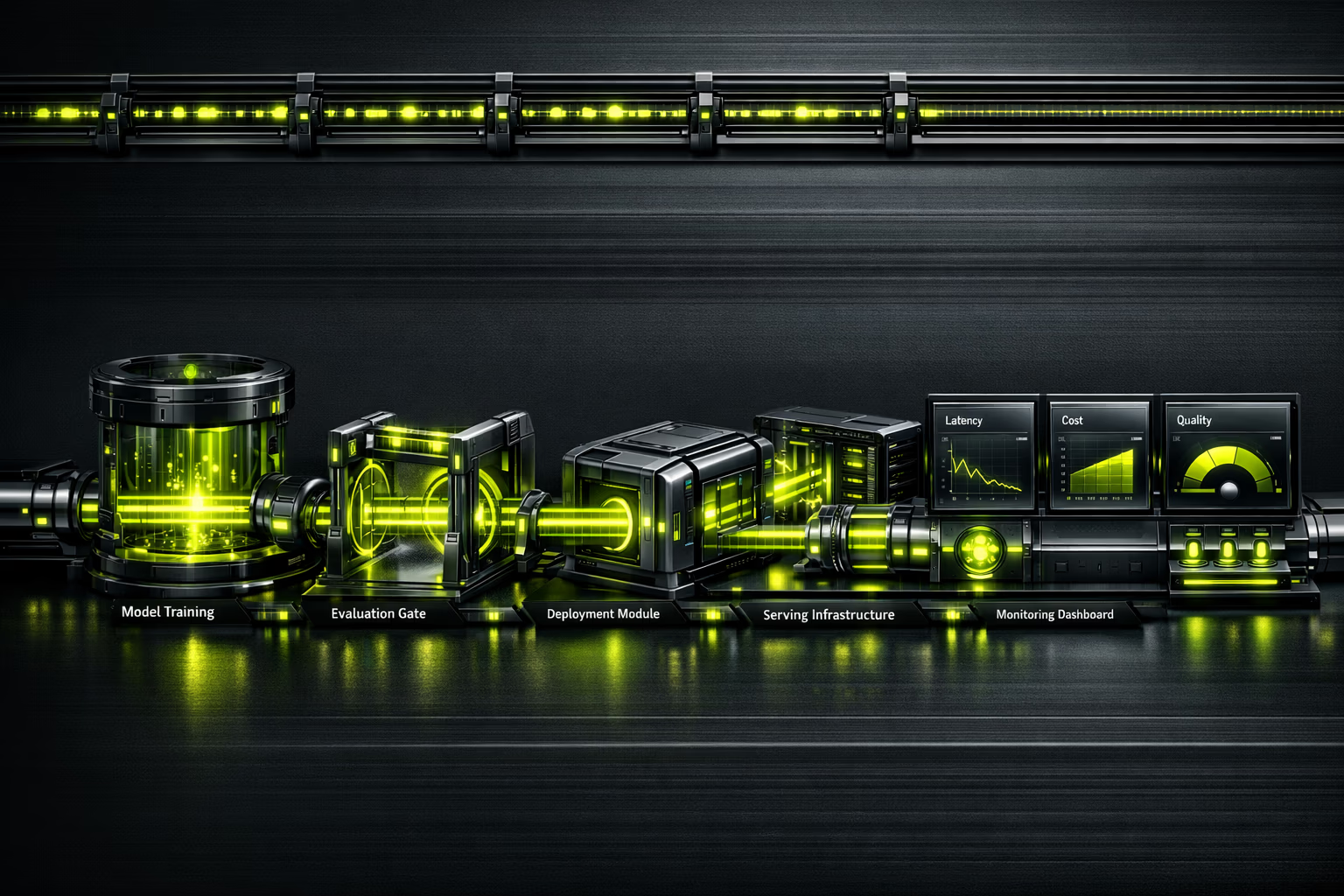

Un model en producció sense observabilitat és una bomba de rellotgeria. LLMOps instrumenta cada crida: latència p50/p95/p99, tokens consumits, cost per request, qualitat de resposta amb avaluacions automatitzades, i detecció d'al·lucinacions. Dashboard unificat perquè el teu equip prengui decisions basades en dades, no en intuïció.

Resum executiu

Per a CEOs i directors d'innovació.

El mercat de MLOps s'estima en $2.4-4.4 mil milions el 2025, amb una projecció de $56-89B per al 2035 (CAGR del 39.8%). La demanda de professionals LLMOps supera àmpliament l'oferta, cosa que fa que externalitzar amb una agència especialitzada sigui la decisió més eficient.

El 87% dels projectes de machine learning mai arriben a producció. No per manca de models, sinó per manca d'infraestructura operativa. LLMOps converteix prototips en actius de negoci: escalables, monitoritzats i amb costos controlats.

Invertir en LLMOps no és un cost addicional; és l'assegurança que la teva inversió en IA genera retorn. Sense operacions, un model que funciona en un notebook és només un experiment car.

Resum per a CTO / equip tècnic

Stack, arquitectura i decisions tècniques.

Model serving: TrueFoundry o vLLM per a inferència d'alt rendiment. Kubernetes (EKS/GKE) per a orquestració. GPU scheduling amb NVIDIA Triton o TGI (Text Generation Inference) de Hugging Face. Autoescalat basat en queue depth, no en CPU.

Avaluació contínua: Braintrust o LangSmith per a eval pipelines. Datasets de referència versionats. Tests de regressió abans de cada deploy. Mètriques de qualitat: coherència, factualitat, rellevància, seguretat. Avaluació humana-in-the-loop per a casos edge.

Observabilitat: Traces amb LangSmith/Braintrust, mètriques amb Prometheus/Grafana, logs estructurats. Detecció de drift amb finestres lliscants. Cost tracking per model, per endpoint, per client. Alertes a PagerDuty/OpsGenie amb runbooks automatitzats.

És per a tu?

LLMOps requereix que ja tinguis models o prototips d'IA. Si encara estàs explorant, comença per consultoria IA.

Per a qui

- Empreses amb prototips d'IA llestos per portar a producció.

- Equips que ja usen LLMs (GPT-4, Claude, Llama) i necessiten escalar.

- Organitzacions amb múltiples models que volen unificar operacions.

- CTOs que necessiten observabilitat i control de costos d'inferència.

- Companyies regulades que requereixen audit logging i guardrails (AI Act, RGPD).

Per a qui no

- Si encara no tens un cas d'ús definit per a IA (comença per consultoria).

- Projectes que es resolen amb una API d'OpenAI sense personalització.

- Empreses sense pressupost per a infraestructura GPU.

- Equips sense capacitat tècnica mínima per operar pipelines.

- Si busques "una IA que ho faci tot sola" — els models requereixen supervisió.

Serveis LLMOps

Verticals operatives per a IA en producció.

Desplegament i serving de models

Containerització de models, desplegament a Kubernetes amb GPU scheduling, autoescalat basat en demanda. Blue-green deployments per a actualitzacions sense downtime.

Prompt engineering com a codi

Prompts versionats a Git, avaluats amb datasets de referència, desplegats amb CI/CD. A/B testing de prompts per optimitzar qualitat i cost simultàniament.

Avaluació i quality assurance

Pipelines d'avaluació automatitzats: factualitat, coherència, seguretat, al·lucinacions. Human-in-the-loop per calibrar avaluadors automàtics. Informes de qualitat abans de cada release.

Observabilitat i monitorització

Traces end-to-end de cada request. Mètriques de latència, throughput, qualitat i cost. Detecció de drift i degradació de rendiment. Dashboards executius i tècnics.

FinOps per a IA

Tracking de cost per request, per model, per client. Caching d'inferències, batching intel·ligent, selecció de models per cost/qualitat. Reducció típica del 30-60% en costos d'inferència.

AgentOps i sistemes agèntics

Monitorització d'agents multi-step: traçabilitat de decisions, control d'eines, circuit breakers i timeouts. El futur de LLMOps és operar agents, no només models.

Procés d'implementació

De prototip a producció amb garanties.

Assessment i disseny

Avaluem els teus models actuals, infraestructura i requisits de producció. Dissenyem l'arquitectura de serving, monitorització i avaluació. Definim SLOs (latència, qualitat, disponibilitat).

Pipeline de CI/CD per a ML

Configurem pipelines de build, test i deploy. Prompt versioning a Git. Eval datasets curats. Tests de regressió automatitzats amb llindars de qualitat.

Desplegament i observabilitat

Model a Kubernetes amb GPU scheduling. Instrumentació completa: traces, mètriques, logs. Dashboards a Grafana. Alertes configurades amb runbooks.

Guardrails i optimització

Filtres de seguretat, validació d'outputs, rate limiting. Optimització de costos: caching, batching, right-sizing. Documentació i traspàs de coneixement.

Operació i millora contínua

Monitorització 24/7. Cicles de re-avaluació amb dades de producció. A/B testing de models i prompts. Informes mensuals de rendiment i costos.

Riscos i mitigació

Operar LLMs té riscos específics. Així els gestionem.

Al·lucinacions en producció

Guardrails amb validació d'outputs, RAG per a grounding, avaluació contínua de factualitat. Taxa objectiu: <2% al·lucinacions crítiques.

Costos d'inferència descontrolats

FinOps des del dia 1: tracking per request, caching intel·ligent, model routing (model econòmic per a queries simples, potent per a complexes). Estalvi típic: 30-60%.

Degradació silenciosa de qualitat

Eval pipelines amb finestres lliscants detecten degradació abans que els usuaris la reportin. Rollback automàtic si la qualitat cau sota el llindar.

Vendor lock-in amb un proveïdor d'IA

Capa d'abstracció que permet canviar entre OpenAI, Anthropic, models open-source sense reescriure l'aplicació. Avaluació comparativa periòdica.

Incompliment regulatori (AI Act)

Audit logging de tota interacció, guardrails de contingut, documentació de decisions del model. Preparats per a classificació de risc segons AI Act.

De notebook a producció en 6 setmanes

E-commerce B2C amb un prototip de chatbot IA en un notebook de Jupyter. Latència de 12 segons per resposta, sense monitorització, costos d'API impredictibles. Implementem LLMOps complet: serving a Kubernetes, caching de respostes freqüents, model routing per complexitat, i guardrails de contingut.

El gap de talent LLMOps

L'oportunitat d'externalitzar.

La demanda de professionals de LLMOps/MLOps supera l'oferta en un ràtio de 5:1. Contractar un equip intern d'operacions d'IA requereix perfils de ML engineer, platform engineer i SRE — salaris que sumen +300K EUR/any. Externalitzar amb Kiwop et dona accés al mateix expertise sense el cost fix ni el risc de rotació.

Preguntes freqüents sobre LLMOps

El que els decisors pregunten abans d'invertir en operacions d'IA.

Quina diferència hi ha entre MLOps i LLMOps?

MLOps és la disciplina general d'operacions per a machine learning: pipelines d'entrenament, serving, monitorització. LLMOps estén MLOps amb pràctiques específiques per a models de llenguatge: prompt versioning, avaluació de qualitat no determinista, control d'al·lucinacions, i optimització de costos de tokens.

Necessito LLMOps si només uso l'API d'OpenAI?

Sí. Usar una API no elimina la necessitat d'operacions: necessites monitoritzar costos, detectar degradació de qualitat, gestionar prompts com a codi, implementar fallbacks quan l'API falla, i complir amb regulacions. LLMOps és més crític com més depens d'IA.

Quant costa la inferència de LLMs en producció?

Depèn del volum i model. GPT-4o: ~$2.5 per milió de tokens d'entrada. Claude Sonnet: ~$3. Models open-source (Llama 3): ~$0.2 amb infraestructura pròpia. L'optimització típica redueix costos un 30-60% amb caching, batching i model routing.

Què és "AgentOps"?

AgentOps és l'evolució de LLMOps per a sistemes agèntics: models que usen eines, prenen decisions multi-step, i col·laboren entre si. Requereix traçabilitat de decisions, circuit breakers, control d'eines, i timeouts. És el futur de les operacions d'IA.

Com s'avalua la qualitat d'un LLM en producció?

Amb pipelines d'avaluació automatitzats que mesuren: factualitat (diu veritats?), coherència (té sentit?), rellevància (respon al que s'ha preguntat?), i seguretat (genera contingut nociu?). Complementat amb avaluació humana periòdica per calibrar els avaluadors automàtics.

Quant de temps es triga a implementar LLMOps?

Pipeline bàsic (serving + monitorització): 4-6 setmanes. Pipeline complet (eval, guardrails, FinOps, CI/CD): 8-12 setmanes. Depèn de la complexitat dels models i la infraestructura existent.

Podem usar models open-source en comptes d'APIs comercials?

Absolutament. Llama 3, Mistral, Qwen són alternatives viables per a molts casos d'ús. L'avantatge: cost predictible, sense dependència de tercers, dades a la teva infraestructura. El trade-off: necessites GPUs i expertise per operar. Avaluem la millor opció per a cada cas.

Com afecta l'AI Act europeu a les operacions d'IA?

L'AI Act classifica sistemes per risc. Per a sistemes d'alt risc: audit logging obligatori, documentació tècnica, transparència, supervisió humana. LLMOps ben implementat cobreix aquests requisits des de disseny: traces completes, guardrails documentats, i logs de totes les interaccions.

Els teus models IA funcionen en un notebook però no en producció?

El 87% dels projectes ML es queden en experimentació. Portem la teva IA a producció amb observabilitat, guardrails i costos controlats.

Parlar amb un ML engineer Auditoria

tècnica inicial.

IA, seguretat i rendiment. Diagnòstic i proposta tancada per fases.

La teva primera reunió és amb un Arquitecte de Solucions, no amb un comercial.

Sol·licitar diagnòstic