LLMOps: breng uw AI-modellen naar echte productie

MLflow · LangSmith · Kubernetes · Guardrails

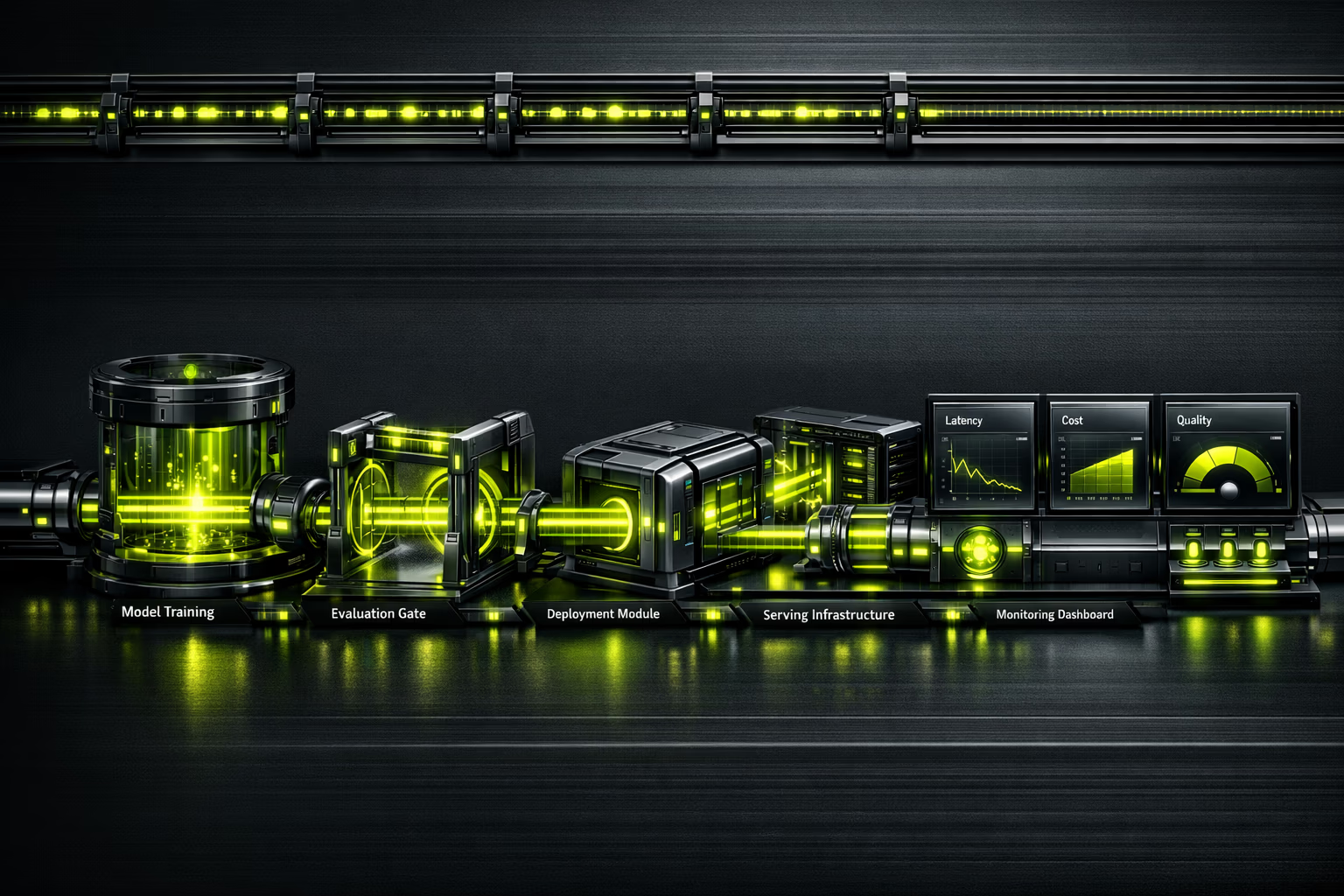

87% van de ML-projecten bereikt nooit productie. LLMOps is de discipline die deze kloof dicht: deployment, monitoring, evaluatie en schaling van taalmodellen met engineering-rigor.

Wat onze LLMOps-dienst omvat

Alles wat u nodig heeft om LLM's met garanties te opereren.

Realtime AI-observability

U kunt niet verbeteren wat u niet meet.

Een model in productie zonder observability is een tikkende tijdbom. LLMOps instrumenteert elke aanroep: latentie p50/p95/p99, verbruikte tokens, kosten per request, antwoordkwaliteit met geautomatiseerde evaluaties, en detectie van hallucinaties. Uniforme dashboard zodat uw team beslissingen neemt op basis van data, niet op basis van intuuetie.

Executive summary

Voor CEO's en innovatiedirecteuren.

De MLOps-markt wordt geschat op $2,4-4,4 miljard in 2025, met een projectie van $56-89B voor 2035 (CAGR van 39,8%). De vraag naar LLMOps-professionals overtreft het aanbod ruimschoots, waardoor uitbesteden aan een gespecialiseerd bureau de meest efficiente beslissing is.

87% van de machine learning projecten bereikt nooit productie. Niet door een gebrek aan modellen, maar door een gebrek aan operationele infrastructuur. LLMOps zet prototypes om in bedrijfsactiva: schaalbaar, gemonitord en met gecontroleerde kosten.

Investeren in LLMOps is geen extra kostenpost; het is de verzekering dat uw AI-investering rendement oplevert. Zonder operaties is een model dat werkt in een notebook slechts een duur experiment.

Samenvatting voor CTO / technisch team

Stack, architectuur en technische beslissingen.

Model serving: TrueFoundry of vLLM voor high-performance inferentie. Kubernetes (EKS/GKE) voor orkestratie. GPU-scheduling met NVIDIA Triton of TGI (Text Generation Inference) van Hugging Face. Autoschaling op basis van wachtrijdiepte, niet CPU.

Continue evaluatie: Braintrust of LangSmith voor eval-pipelines. Geversioned referentiedatasets. Regressietests voor elke deploy. Kwaliteitsmetrics: coherentie, feitelijkheid, relevantie, veiligheid. Human-in-the-loop evaluatie voor edge cases.

Observability: traces met LangSmith/Braintrust, metrics met Prometheus/Grafana, gestructureerde logs. Driftdetectie met schuivende vensters. Kostentracking per model, per endpoint, per klant. Alerts in PagerDuty/OpsGenie met geautomatiseerde runbooks.

Is het voor u?

LLMOps vereist dat u al modellen of AI-prototypes heeft. Als u nog verkent, begin dan met AI-consultancy.

Voor wie

- Bedrijven met AI-prototypes die klaar zijn voor productie.

- Teams die al LLM's gebruiken (GPT-4, Claude, Llama) en moeten schalen.

- Organisaties met meerdere modellen die operaties willen unificeren.

- CTO's die observability en kostenbeheersing van inferentie nodig hebben.

- Gereguleerde bedrijven die audit logging en guardrails vereisen (AI Act, AVG).

Voor wie niet

- Als u nog geen gedefinieerd AI-gebruik heeft (begin met consultancy).

- Projecten die opgelost worden met een OpenAI API zonder aanpassing.

- Bedrijven zonder budget voor GPU-infrastructuur.

- Teams zonder minimale technische capaciteit om pipelines te opereren.

- Als u "een AI zoekt die alles zelf doet" — modellen vereisen supervisie.

LLMOps-diensten

Operationele verticals voor AI in productie.

Modelimplementatie en serving

Containerisatie van modellen, deployment op Kubernetes met GPU-scheduling, autoschaling op basis van vraag. Blue-green deployments voor updates zonder downtime.

Prompt engineering als code

Prompts geversioned in Git, geevalueerd met referentiedatasets, gedeployed met CI/CD. A/B testing van prompts om kwaliteit en kosten tegelijk te optimaliseren.

Evaluatie en quality assurance

Geautomatiseerde evaluatiepipelines: feitelijkheid, coherentie, veiligheid, hallucinaties. Human-in-the-loop om automatische evaluatoren te kalibreren. Kwaliteitsrapportages voor elke release.

Observability en monitoring

End-to-end traces van elke request. Metrics voor latentie, throughput, kwaliteit en kosten. Driftdetectie en prestatiedegradatie. Executive en technische dashboards.

FinOps voor AI

Kostentracking per request, per model, per klant. Inferentiecaching, intelligent batching, modelselectie op kosten/kwaliteit. Typische reductie van 30-60% in inferentiekosten.

AgentOps en agentische systemen

Monitoring van multi-step agents: traceerbaarheid van beslissingen, toolbeheer, circuit breakers en timeouts. De toekomst van LLMOps is het opereren van agents, niet alleen modellen.

Implementatieproces

Van prototype naar productie met garanties.

Assessment en ontwerp

We evalueren uw huidige modellen, infrastructuur en productie-eisen. We ontwerpen de architectuur voor serving, monitoring en evaluatie. We definiueren SLO's (latentie, kwaliteit, beschikbaarheid).

CI/CD-pipeline voor ML

We configureren pipelines voor build, test en deploy. Prompt versioning in Git. Gecureerde eval-datasets. Geautomatiseerde regressietests met kwaliteitsdrempels.

Deployment en observability

Model op Kubernetes met GPU-scheduling. Volledige instrumentatie: traces, metrics, logs. Dashboards in Grafana. Geconfigureerde alerts met runbooks.

Guardrails en optimalisatie

Veiligheidsfilters, outputvalidatie, rate limiting. Kostenoptimalisatie: caching, batching, right-sizing. Documentatie en kennisoverdracht.

Operatie en continue verbetering

24/7 monitoring. Herevaluatiecycli met productiedata. A/B testing van modellen en prompts. Maandelijkse prestatie- en kostenrapportages.

Risico's en beperking

Het opereren van LLM's brengt specifieke risico's met zich mee. Zo beheersen wij ze.

Hallucinaties in productie

Guardrails met outputvalidatie, RAG voor grounding, continue evaluatie van feitelijkheid. Doelpercentage: <2% kritieke hallucinaties.

Ongecontroleerde inferentiekosten

FinOps vanaf dag 1: tracking per request, intelligent caching, model routing (goedkoop model voor eenvoudige queries, krachtig voor complexe). Typische besparing: 30-60%.

Stille kwaliteitsdegradatie

Eval-pipelines met schuivende vensters detecteren degradatie voordat gebruikers het melden. Automatische rollback als kwaliteit onder drempel daalt.

Vendor lock-in bij een AI-leverancier

Abstractielaag die wisselen tussen OpenAI, Anthropic en open-source modellen mogelijk maakt zonder de applicatie te herschrijven. Periodieke vergelijkende evaluatie.

Niet-naleving van regelgeving (AI Act)

Audit logging van alle interacties, contentguardrails, documentatie van modelbeslissingen. Voorbereid op risicoclassificatie volgens de AI Act.

Van notebook naar productie in 6 weken

B2C e-commerce met een AI-chatbot prototype in een Jupyter notebook. Latentie van 12 seconden per antwoord, geen monitoring, onvoorspelbare API-kosten. We implementeerden volledig LLMOps: serving op Kubernetes, caching van veelvoorkomende antwoorden, model routing op complexiteit, en contentguardrails.

De LLMOps talentkloof

De kans om uit te besteden.

De vraag naar LLMOps/MLOps-professionals overtreft het aanbod in een verhouding van 5:1. Een intern AI-operatieteam aannemen vereist profielen van ML engineer, platform engineer en SRE — salarissen die optellen tot meer dan €300K/jaar. Uitbesteden aan Kiwop geeft u toegang tot dezelfde expertise zonder de vaste kosten en het verlooprisico.

Veelgestelde vragen over LLMOps

Wat beslissers vragen voordat ze investeren in AI-operaties.

Wat is het verschil tussen MLOps en LLMOps?

MLOps is de algemene discipline van operaties voor machine learning: trainingspipelines, serving, monitoring. LLMOps breidt MLOps uit met praktijken specifiek voor taalmodellen: prompt versioning, evaluatie van niet-deterministische kwaliteit, beheersing van hallucinaties, en optimalisatie van tokenkosten.

Heb ik LLMOps nodig als ik alleen de OpenAI API gebruik?

Ja. Het gebruik van een API elimineert niet de noodzaak van operaties: u moet kosten monitoren, kwaliteitsdegradatie detecteren, prompts als code beheren, fallbacks implementeren als de API faalt, en voldoen aan regelgeving. LLMOps is des te kritischer naarmate u meer afhankelijk bent van AI.

Hoeveel kost LLM-inferentie in productie?

Dat hangt af van volume en model. GPT-4o: ~$2,5 per miljoen invoertokens. Claude Sonnet: ~$3. Open-source modellen (Llama 3): ~$0,2 met eigen infrastructuur. De typische optimalisatie verlaagt kosten met 30-60% door caching, batching en model routing.

Wat is "AgentOps"?

AgentOps is de evolutie van LLMOps voor agentische systemen: modellen die tools gebruiken, multi-step beslissingen nemen en onderling samenwerken. Het vereist traceerbaarheid van beslissingen, circuit breakers, toolbeheer en timeouts. Het is de toekomst van AI-operaties.

Hoe evalueer je de kwaliteit van een LLM in productie?

Met geautomatiseerde evaluatiepipelines die meten: feitelijkheid (vertelt het de waarheid?), coherentie (is het logisch?), relevantie (beantwoordt het de vraag?), en veiligheid (produceert het schadelijke content?). Aangevuld met periodieke menselijke evaluatie om de automatische evaluatoren te kalibreren.

Hoe lang duurt het om LLMOps te implementeren?

Basispipeline (serving + monitoring): 4-6 weken. Volledige pipeline (eval, guardrails, FinOps, CI/CD): 8-12 weken. Afhankelijk van de complexiteit van de modellen en de bestaande infrastructuur.

Kunnen we open-source modellen gebruiken in plaats van commerciele APIs?

Absoluut. Llama 3, Mistral, Qwen zijn levensvatbare alternatieven voor veel use cases. Het voordeel: voorspelbare kosten, geen afhankelijkheid van derden, data op uw infrastructuur. De afweging: u heeft GPU's en expertise nodig om te opereren. Wij evalueren de beste optie per geval.

Hoe beinvloedt de Europese AI Act de AI-operaties?

De AI Act classificeert systemen op risico. Voor systemen met hoog risico: verplichte audit logging, technische documentatie, transparantie, menselijk toezicht. Goed geimplementeerd LLMOps dekt deze vereisten by design: volledige traces, gedocumenteerde guardrails, en logs van alle interacties.

Werken uw AI-modellen in een notebook maar niet in productie?

87% van de ML-projecten blijft in de experimenteerfase. Wij brengen uw AI naar productie met observability, guardrails en gecontroleerde kosten.

Spreek met een ML engineer Technische

initiële audit.

AI, beveiliging en prestaties. Diagnose met gefaseerd voorstel.

Je eerste gesprek is met een Solutions Architect, niet met een verkoper.

Diagnose aanvragen