LLMOps : déployez vos modèles d'IA en production réelle

MLflow · LangSmith · Kubernetes · Guardrails

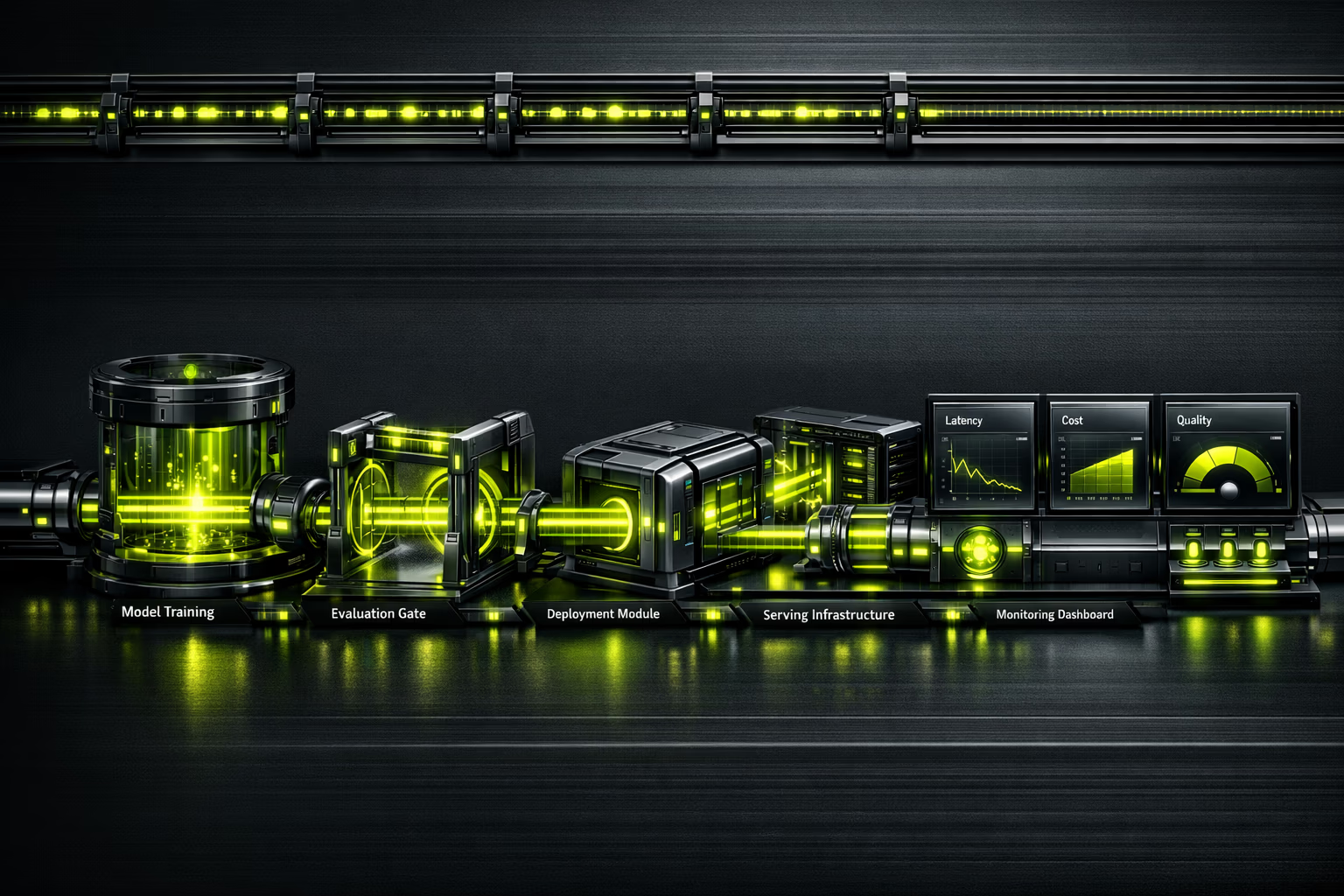

87 % des projets de ML n'atteignent jamais la production. LLMOps est la discipline qui comble ce fosse : deploiement, surveillance, evaluation et mise a l'echelle des modeles de langage avec une rigueur d'ingenierie.

Ce qu'inclut notre service LLMOps

Tout ce qu'il faut pour operer des LLM avec des garanties.

Observabilite de l'IA en temps reel

On ne peut pas ameliorer ce qu'on ne mesure pas.

Un modele en production sans observabilite est une bombe a retardement. LLMOps instrumente chaque appel : latence p50/p95/p99, tokens consommes, cout par requete, qualite des reponses avec evaluations automatisees, et detection des hallucinations. Dashboard unifie pour que votre equipe prenne des decisions basees sur les donnees, pas sur l'intuition.

Resume executif

Pour les CEO et directeurs de l'innovation.

Le marche MLOps est estime a 2,4 a 4,4 milliards de dollars en 2025, avec une projection de 56 a 89 milliards pour 2035 (CAGR de 39,8 %). La demande de professionnels LLMOps depasse largement l'offre, ce qui fait de l'externalisation avec une agence specialisee la decision la plus efficiente.

87 % des projets de machine learning n'atteignent jamais la production. Non pas par manque de modeles, mais par manque d'infrastructure operationnelle. LLMOps transforme les prototypes en actifs business : scalables, surveilles et avec des couts maitrises.

Investir dans LLMOps n'est pas un cout supplementaire ; c'est l'assurance que votre investissement en IA genere un retour. Sans operations, un modele qui fonctionne dans un notebook n'est qu'une experience couteuse.

Resume pour le CTO / equipe technique

Stack, architecture et decisions techniques.

Model serving : TrueFoundry ou vLLM pour l'inference haute performance. Kubernetes (EKS/GKE) pour l'orchestration. GPU scheduling avec NVIDIA Triton ou TGI (Text Generation Inference) de Hugging Face. Autoscaling base sur la profondeur de file, pas le CPU.

Evaluation continue : Braintrust ou LangSmith pour les pipelines d'evaluation. Datasets de reference versionnes. Tests de regression avant chaque deploiement. Metriques de qualite : coherence, factualite, pertinence, securite. Evaluation humaine-in-the-loop pour les cas limites.

Observabilite : traces avec LangSmith/Braintrust, metriques avec Prometheus/Grafana, logs structures. Detection de drift avec fenetres glissantes. Suivi des couts par modele, par endpoint, par client. Alertes dans PagerDuty/OpsGenie avec runbooks automatises.

Est-ce pour vous ?

LLMOps necessite que vous ayez deja des modeles ou des prototypes d'IA. Si vous en etes encore a l'exploration, commencez par le conseil en IA.

Pour qui

- Entreprises avec des prototypes d'IA prets a passer en production.

- Equipes qui utilisent deja des LLM (GPT-4, Claude, Llama) et ont besoin de monter en charge.

- Organisations avec plusieurs modeles qui souhaitent unifier les operations.

- CTO qui ont besoin d'observabilite et de controle des couts d'inference.

- Entreprises reglementees qui necessitent audit logging et guardrails (AI Act, RGPD).

Pour qui pas

- Si vous n'avez pas encore de cas d'usage defini pour l'IA (commencez par le conseil).

- Projets qui se resolvent avec une API OpenAI sans personnalisation.

- Entreprises sans budget pour l'infrastructure GPU.

- Equipes sans capacite technique minimale pour operer des pipelines.

- Si vous cherchez "une IA qui fait tout toute seule" — les modeles necessitent de la supervision.

Services LLMOps

Verticales operationnelles pour l'IA en production.

Déploiement et serving de modèles

Containerisation de modeles, deploiement sur Kubernetes avec GPU scheduling, autoscaling base sur la demande. Deploiements blue-green pour des mises a jour sans downtime.

Prompt engineering comme du code

Prompts versionnes dans Git, evalues avec des datasets de reference, deployes en CI/CD. A/B testing de prompts pour optimiser la qualite et le cout simultanement.

Evaluation et assurance qualite

Pipelines d'evaluation automatises : factualite, coherence, securite, hallucinations. Human-in-the-loop pour calibrer les evaluateurs automatiques. Rapports de qualite avant chaque release.

Observabilité et surveillance

Traces end-to-end de chaque requete. Metriques de latence, debit, qualite et cout. Detection de drift et degradation de performance. Dashboards executifs et techniques.

FinOps pour l'IA

Suivi des couts par requete, par modele, par client. Caching d'inferences, batching intelligent, selection de modeles par cout/qualite. Reduction typique de 30 a 60 % des couts d'inference.

AgentOps et systèmes agentiques

Surveillance d'agents multi-step : tracabilite des decisions, controle des outils, circuit breakers et timeouts. L'avenir de LLMOps est d'operer des agents, pas seulement des modeles.

Processus d'implementation

Du prototype a la production avec des garanties.

Assessment et conception

Nous evaluons vos modeles actuels, votre infrastructure et vos exigences de production. Nous concevons l'architecture de serving, de surveillance et d'evaluation. Nous definissons les SLO (latence, qualite, disponibilite).

Pipeline CI/CD pour le ML

Nous configurons les pipelines de build, test et deploiement. Prompt versioning dans Git. Datasets d'evaluation organises. Tests de regression automatises avec seuils de qualite.

Deploiement et observabilite

Modele dans Kubernetes avec GPU scheduling. Instrumentation complete : traces, metriques, logs. Dashboards dans Grafana. Alertes configurees avec runbooks.

Guardrails et optimisation

Filtres de securite, validation des outputs, rate limiting. Optimisation des couts : caching, batching, right-sizing. Documentation et transfert de connaissances.

Operation et amelioration continue

Surveillance 24/7. Cycles de re-evaluation avec donnees de production. A/B testing de modeles et prompts. Rapports mensuels de performance et couts.

Risques et attenuation

Operer des LLM comporte des risques specifiques. Voici comment nous les gerons.

Hallucinations en production

Guardrails avec validation des outputs, RAG pour le grounding, evaluation continue de la factualite. Taux cible : <2 % d'hallucinations critiques.

Couts d'inference incontroles

FinOps des le jour 1 : suivi par requete, caching intelligent, model routing (modele economique pour les requetes simples, puissant pour les complexes). Economie typique : 30 a 60 %.

Degradation silencieuse de la qualite

Des pipelines d'evaluation avec fenetres glissantes detectent la degradation avant que les utilisateurs ne la signalent. Rollback automatique si la qualite tombe sous le seuil.

Dependance a un fournisseur d'IA

Couche d'abstraction permettant de basculer entre OpenAI, Anthropic, modeles open-source sans reecrire l'application. Evaluation comparative periodique.

Non-conformite reglementaire (AI Act)

Audit logging de toute interaction, guardrails de contenu, documentation des decisions du modele. Prets pour la classification de risque selon l'AI Act.

Du notebook a la production en 6 semaines

E-commerce B2C avec un prototype de chatbot IA dans un notebook Jupyter. Latence de 12 secondes par reponse, sans surveillance, couts d'API imprevisibles. Nous avons implemente un LLMOps complet : serving sur Kubernetes, caching des reponses frequentes, model routing par complexite, et guardrails de contenu.

Le deficit de talents LLMOps

L'opportunite d'externaliser.

La demande de professionnels LLMOps/MLOps depasse l'offre dans un ratio de 5:1. Recruter une equipe interne d'operations IA necessite des profils de ML engineer, platform engineer et SRE — des salaires cumules de plus de 300 000 EUR/an. Externaliser avec Kiwop vous donne acces a la meme expertise sans le cout fixe ni le risque de turnover.

Questions frequentes sur LLMOps

Ce que les decideurs demandent avant d'investir dans les operations d'IA.

Quelle difference entre MLOps et LLMOps ?

MLOps est la discipline generale des operations pour le machine learning : pipelines d'entrainement, serving, surveillance. LLMOps etend MLOps avec des pratiques specifiques aux modeles de langage : prompt versioning, evaluation de qualite non deterministe, controle des hallucinations, et optimisation des couts en tokens.

Ai-je besoin de LLMOps si j'utilise uniquement l'API OpenAI ?

Oui. Utiliser une API n'elimine pas le besoin d'operations : vous devez surveiller les couts, detecter la degradation de qualite, gerer les prompts comme du code, implementer des fallbacks quand l'API echoue, et respecter les reglementations. LLMOps est d'autant plus critique que vous dependez de l'IA.

Combien coute l'inference des LLM en production ?

Cela depend du volume et du modele. GPT-4o : environ 2,5 $ par million de tokens d'entree. Claude Sonnet : environ 3 $. Modeles open-source (Llama 3) : environ 0,2 $ avec infrastructure propre. L'optimisation typique reduit les couts de 30 a 60 % avec caching, batching et model routing.

Qu'est-ce que l'"AgentOps" ?

AgentOps est l'evolution de LLMOps pour les systemes agentiques : des modeles qui utilisent des outils, prennent des decisions multi-step et collaborent entre eux. Cela necessite la tracabilite des decisions, des circuit breakers, le controle des outils et des timeouts. C'est l'avenir des operations d'IA.

Comment evalue-t-on la qualite d'un LLM en production ?

Avec des pipelines d'evaluation automatises qui mesurent : factualite (dit-il vrai ?), coherence (est-ce logique ?), pertinence (repond-il a la question ?), et securite (genere-t-il du contenu nuisible ?). Complete par une evaluation humaine periodique pour calibrer les evaluateurs automatiques.

Combien de temps faut-il pour implementer LLMOps ?

Pipeline basique (serving + surveillance) : 4 a 6 semaines. Pipeline complet (evaluation, guardrails, FinOps, CI/CD) : 8 a 12 semaines. Cela depend de la complexite des modeles et de l'infrastructure existante.

Pouvons-nous utiliser des modeles open-source au lieu d'APIs commerciales ?

Absolument. Llama 3, Mistral, Qwen sont des alternatives viables pour de nombreux cas d'usage. L'avantage : cout previsible, pas de dependance tierce, donnees dans votre infrastructure. Le compromis : vous avez besoin de GPU et d'expertise pour operer. Nous evaluons la meilleure option au cas par cas.

Comment l'AI Act europeen affecte-t-il les operations d'IA ?

L'AI Act classe les systemes par risque. Pour les systemes a haut risque : audit logging obligatoire, documentation technique, transparence, supervision humaine. Un LLMOps bien implemente couvre ces exigences des la conception : traces completes, guardrails documentes et logs de toutes les interactions.

Vos modeles IA fonctionnent dans un notebook mais pas en production ?

87 % des projets ML restent au stade experimental. Nous mettons votre IA en production avec observabilite, guardrails et couts maitrises.

Parler a un ML engineer Audit

technique initial.

IA, sécurité et performance. Diagnostic avec proposition par phases.

Votre premier rendez-vous est avec un Architecte Solutions, pas un commercial.

Demander un diagnostic