LLMOps: leve os seus modelos de IA para produção real

MLflow · LangSmith · Kubernetes · Guardrails

87% dos projetos de ML nunca chegam a producao. LLMOps e a disciplina que fecha essa lacuna: deployment, monitorizacao, avaliacao e escalamento de modelos de linguagem com rigor de engenharia.

O que inclui o nosso servico LLMOps

Tudo o que precisa para operar LLMs com garantias.

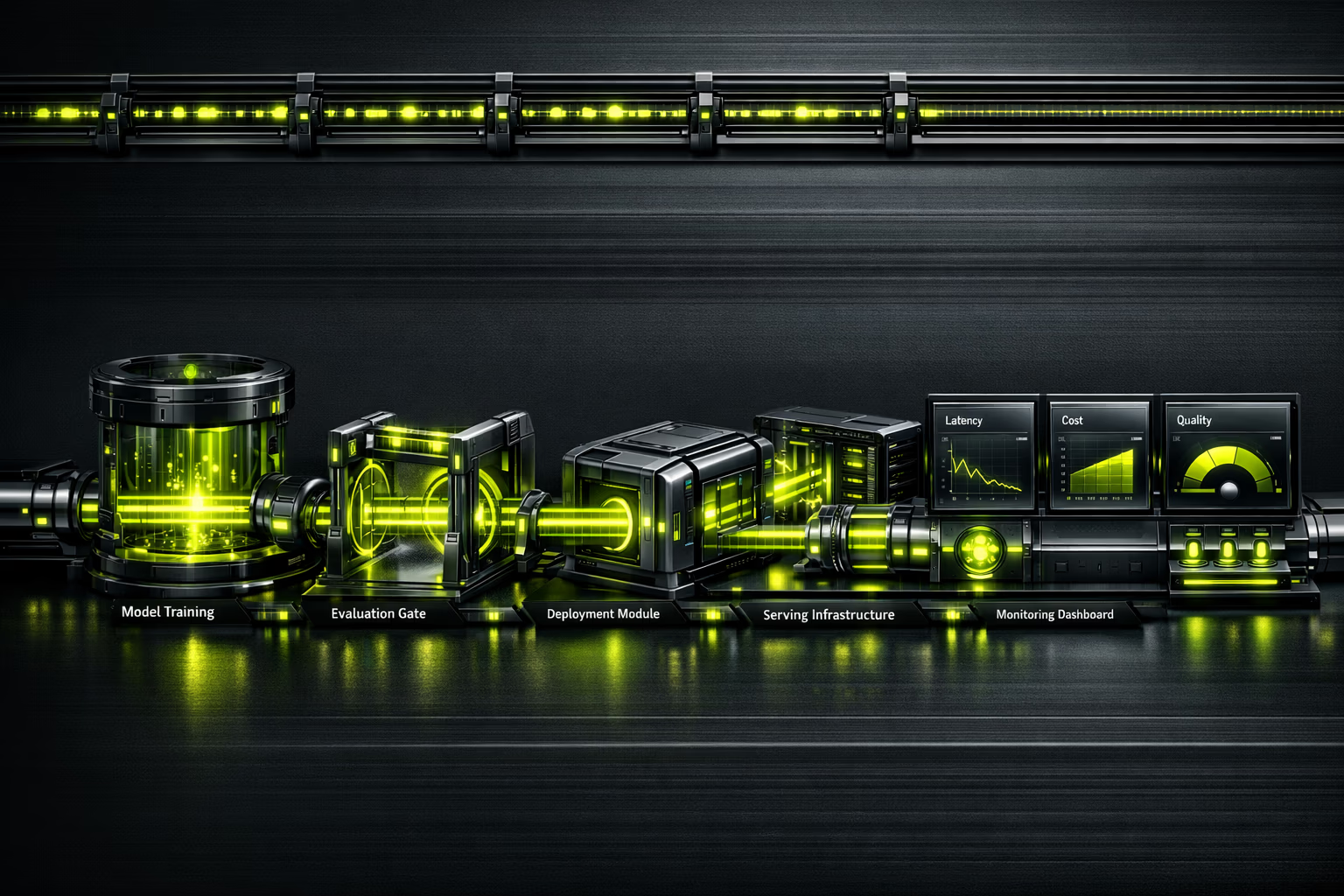

Observabilidade de IA em tempo real

Nao se pode melhorar o que nao se mede.

Um modelo em producao sem observabilidade e uma bomba-relogio. LLMOps instrumenta cada chamada: latencia p50/p95/p99, tokens consumidos, custo por request, qualidade de resposta com avaliacoes automatizadas, e detecao de alucinacoes. Dashboard unificado para que a sua equipa tome decisoes baseadas em dados, nao em intuicao.

Resumo executivo

Para CEOs e diretores de inovacao.

O mercado de MLOps estima-se em $2.4-4.4 mil milhoes em 2025, com uma projecao de $56-89B para 2035 (CAGR de 39.8%). A procura de profissionais LLMOps supera amplamente a oferta, o que torna a externalizacao com uma agencia especializada a decisao mais eficiente.

87% dos projetos de machine learning nunca chegam a producao. Nao por falta de modelos, mas por falta de infraestrutura operacional. LLMOps converte prototipos em ativos de negocio: escalaveis, monitorizados e com custos controlados.

Investir em LLMOps nao e um custo adicional; e o seguro de que o seu investimento em IA gera retorno. Sem operacoes, um modelo que funciona num notebook e apenas uma experiencia cara.

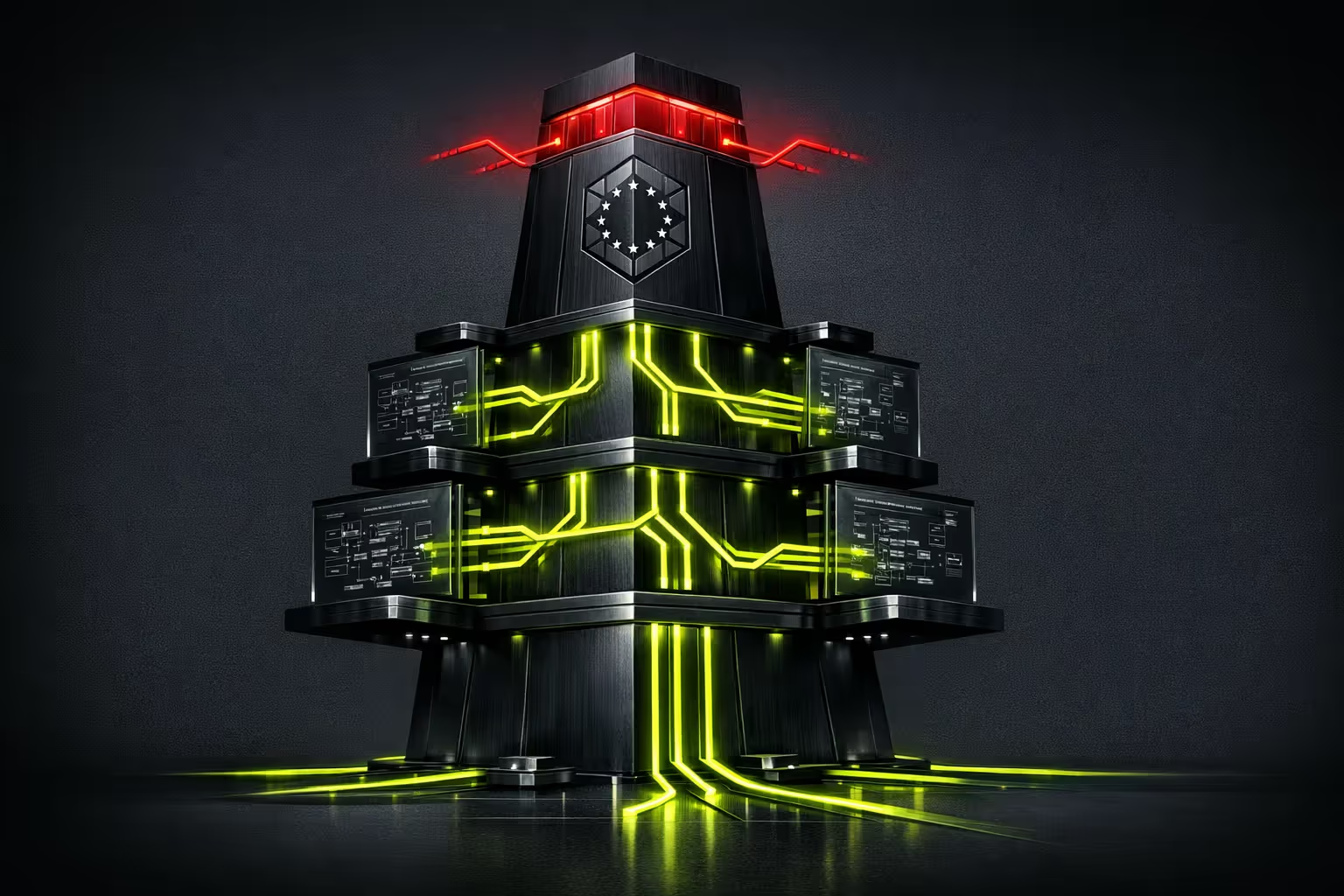

Resumo para CTO / equipa tecnica

Stack, arquitetura e decisoes tecnicas.

Model serving: TrueFoundry ou vLLM para inferencia de alto desempenho. Kubernetes (EKS/GKE) para orquestracao. GPU scheduling com NVIDIA Triton ou TGI (Text Generation Inference) da Hugging Face. Autoescalamento baseado em queue depth, nao em CPU.

Avaliacao continua: Braintrust ou LangSmith para eval pipelines. Datasets de referencia versionados. Testes de regressao antes de cada deploy. Metricas de qualidade: coerencia, factualidade, relevancia, seguranca. Avaliacao humana-in-the-loop para casos edge.

Observabilidade: Tracas com LangSmith/Braintrust, metricas com Prometheus/Grafana, logs estruturados. Detecao de drift com janelas deslizantes. Cost tracking por modelo, por endpoint, por cliente. Alertas em PagerDuty/OpsGenie com runbooks automatizados.

E para si?

LLMOps requer que ja tenha modelos ou prototipos de IA. Se ainda esta a explorar, comece pela consultoria IA.

Para quem

- Empresas com prototipos de IA prontos para levar a producao.

- Equipas que ja usam LLMs (GPT-4, Claude, Llama) e precisam de escalar.

- Organizacoes com multiplos modelos que querem unificar operacoes.

- CTOs que precisam de observabilidade e controlo de custos de inferencia.

- Empresas reguladas que requerem audit logging e guardrails (AI Act, RGPD).

Para quem não

- Se ainda nao tem um caso de uso definido para IA (comece pela consultoria).

- Projetos que se resolvem com uma API da OpenAI sem personalizacao.

- Empresas sem orcamento para infraestrutura GPU.

- Equipas sem capacidade tecnica minima para operar pipelines.

- Se procura "uma IA que faca tudo sozinha" — os modelos requerem supervisao.

Servicos LLMOps

Verticais operacionais para IA em producao.

Deployment e serving de modelos

Containerizacao de modelos, deployment em Kubernetes com GPU scheduling, autoescalamento baseado na procura. Blue-green deployments para atualizacoes sem downtime.

Prompt engineering como codigo

Prompts versionados em Git, avaliados com datasets de referencia, deployados com CI/CD. A/B testing de prompts para otimizar qualidade e custo simultaneamente.

Avaliacao e quality assurance

Pipelines de avaliacao automatizados: factualidade, coerencia, seguranca, alucinacoes. Human-in-the-loop para calibrar avaliadores automaticos. Relatorios de qualidade antes de cada release.

Observabilidade e monitorização

Tracas end-to-end de cada request. Metricas de latencia, throughput, qualidade e custo. Detecao de drift e degradacao de desempenho. Dashboards executivos e tecnicos.

FinOps para IA

Tracking de custo por request, por modelo, por cliente. Caching de inferencias, batching inteligente, selecao de modelos por custo/qualidade. Reducao tipica de 30-60% em custos de inferencia.

AgentOps e sistemas agênticos

Monitorizacao de agentes multi-step: rastreabilidade de decisoes, controlo de ferramentas, circuit breakers e timeouts. O futuro do LLMOps e operar agentes, nao apenas modelos.

Processo de implementacao

De prototipo a producao com garantias.

Assessment e desenho

Avaliamos os seus modelos atuais, infraestrutura e requisitos de producao. Desenhamos a arquitetura de serving, monitorizacao e avaliacao. Definimos SLOs (latencia, qualidade, disponibilidade).

Pipeline de CI/CD para ML

Configuramos pipelines de build, test e deploy. Prompt versioning em Git. Eval datasets curados. Testes de regressao automatizados com limiares de qualidade.

Deployment e observabilidade

Modelo em Kubernetes com GPU scheduling. Instrumentacao completa: tracas, metricas, logs. Dashboards em Grafana. Alertas configuradas com runbooks.

Guardrails e otimizacao

Filtros de seguranca, validacao de outputs, rate limiting. Otimizacao de custos: caching, batching, right-sizing. Documentacao e transferencia de conhecimento.

Operacao e melhoria continua

Monitorizacao 24/7. Ciclos de reavaliacao com dados de producao. A/B testing de modelos e prompts. Relatorios mensais de desempenho e custos.

Riscos e mitigacao

Operar LLMs tem riscos especificos. E assim que os gerimos.

Alucinacoes em producao

Guardrails com validacao de outputs, RAG para grounding, avaliacao continua de factualidade. Taxa objetivo: <2% alucinacoes criticas.

Custos de inferencia descontrolados

FinOps desde o dia 1: tracking por request, caching inteligente, model routing (modelo barato para queries simples, potente para complexas). Poupanca tipica: 30-60%.

Degradacao silenciosa de qualidade

Eval pipelines com janelas deslizantes detetam degradacao antes de os utilizadores a reportarem. Rollback automatico se a qualidade cair abaixo do limiar.

Vendor lock-in com um fornecedor de IA

Camada de abstracao que permite alternar entre OpenAI, Anthropic, modelos open-source sem reescrever a aplicacao. Avaliacao comparativa periodica.

Incumprimento regulatorio (AI Act)

Audit logging de toda a interacao, guardrails de conteudo, documentacao de decisoes do modelo. Preparados para classificacao de risco segundo o AI Act.

De notebook a producao em 6 semanas

E-commerce B2C com um prototipo de chatbot IA num notebook Jupyter. Latencia de 12 segundos por resposta, sem monitorizacao, custos de API imprevisiveis. Implementamos LLMOps completo: serving em Kubernetes, caching de respostas frequentes, model routing por complexidade, e guardrails de conteudo.

A lacuna de talento LLMOps

A oportunidade de externalizar.

A procura de profissionais de LLMOps/MLOps supera a oferta numa proporcao de 5:1. Contratar uma equipa interna de operacoes de IA requer perfis de ML engineer, platform engineer e SRE — salarios que somam +300K EUR/ano. Externalizar com a Kiwop da-lhe acesso ao mesmo expertise sem o custo fixo nem o risco de rotacao.

Perguntas frequentes sobre LLMOps

O que os decisores perguntam antes de investir em operacoes de IA.

Qual a diferenca entre MLOps e LLMOps?

MLOps e a disciplina geral de operacoes para machine learning: pipelines de treino, serving, monitorizacao. LLMOps estende o MLOps com praticas especificas para modelos de linguagem: prompt versioning, avaliacao de qualidade nao deterministica, controlo de alucinacoes, e otimizacao de custos de tokens.

Preciso de LLMOps se so uso a API da OpenAI?

Sim. Usar uma API nao elimina a necessidade de operacoes: precisa de monitorizar custos, detetar degradacao de qualidade, gerir prompts como codigo, implementar fallbacks quando a API falha, e cumprir regulamentacoes. LLMOps e mais critico quanto mais depende de IA.

Quanto custa a inferencia de LLMs em producao?

Depende do volume e modelo. GPT-4o: ~$2.5 por milhao de tokens de entrada. Claude Sonnet: ~$3. Modelos open-source (Llama 3): ~$0.2 com infraestrutura propria. A otimizacao tipica reduz custos 30-60% com caching, batching e model routing.

O que e "AgentOps"?

AgentOps e a evolucao do LLMOps para sistemas agenticos: modelos que usam ferramentas, tomam decisoes multi-step, e colaboram entre si. Requer rastreabilidade de decisoes, circuit breakers, controlo de ferramentas, e timeouts. E o futuro das operacoes de IA.

Como se avalia a qualidade de um LLM em producao?

Com pipelines de avaliacao automatizados que medem: factualidade (diz verdades?), coerencia (faz sentido?), relevancia (responde ao que foi perguntado?), e seguranca (gera conteudo nocivo?). Complementado com avaliacao humana periodica para calibrar os avaliadores automaticos.

Quanto tempo demora a implementar LLMOps?

Pipeline basico (serving + monitorizacao): 4-6 semanas. Pipeline completo (eval, guardrails, FinOps, CI/CD): 8-12 semanas. Depende da complexidade dos modelos e da infraestrutura existente.

Podemos usar modelos open-source em vez de APIs comerciais?

Absolutamente. Llama 3, Mistral, Qwen sao alternativas viaveis para muitos casos de uso. A vantagem: custo previsivel, sem dependencia de terceiros, dados na sua infraestrutura. O trade-off: precisa de GPUs e expertise para operar. Avaliamos a melhor opcao para cada caso.

Como afeta o AI Act europeu as operacoes de IA?

O AI Act classifica sistemas por risco. Para sistemas de alto risco: audit logging obrigatorio, documentacao tecnica, transparencia, supervisao humana. LLMOps bem implementado cobre estes requisitos desde a concecao: tracas completas, guardrails documentados, e logs de todas as interacoes.

Os seus modelos IA funcionam num notebook mas nao em producao?

87% dos projetos ML ficam na experimentacao. Levamos a sua IA para producao com observabilidade, guardrails e custos controlados.

Falar com um ML engineer Auditoria

técnica inicial.

IA, segurança e desempenho. Diagnóstico com proposta faseada.

A sua primeira reunião é com um Arquiteto de Soluções, não com um comercial.

Solicitar diagnóstico