LLMOps: Bringen Sie Ihre KI-Modelle in echte Produktion

MLflow · LangSmith · Kubernetes · Guardrails

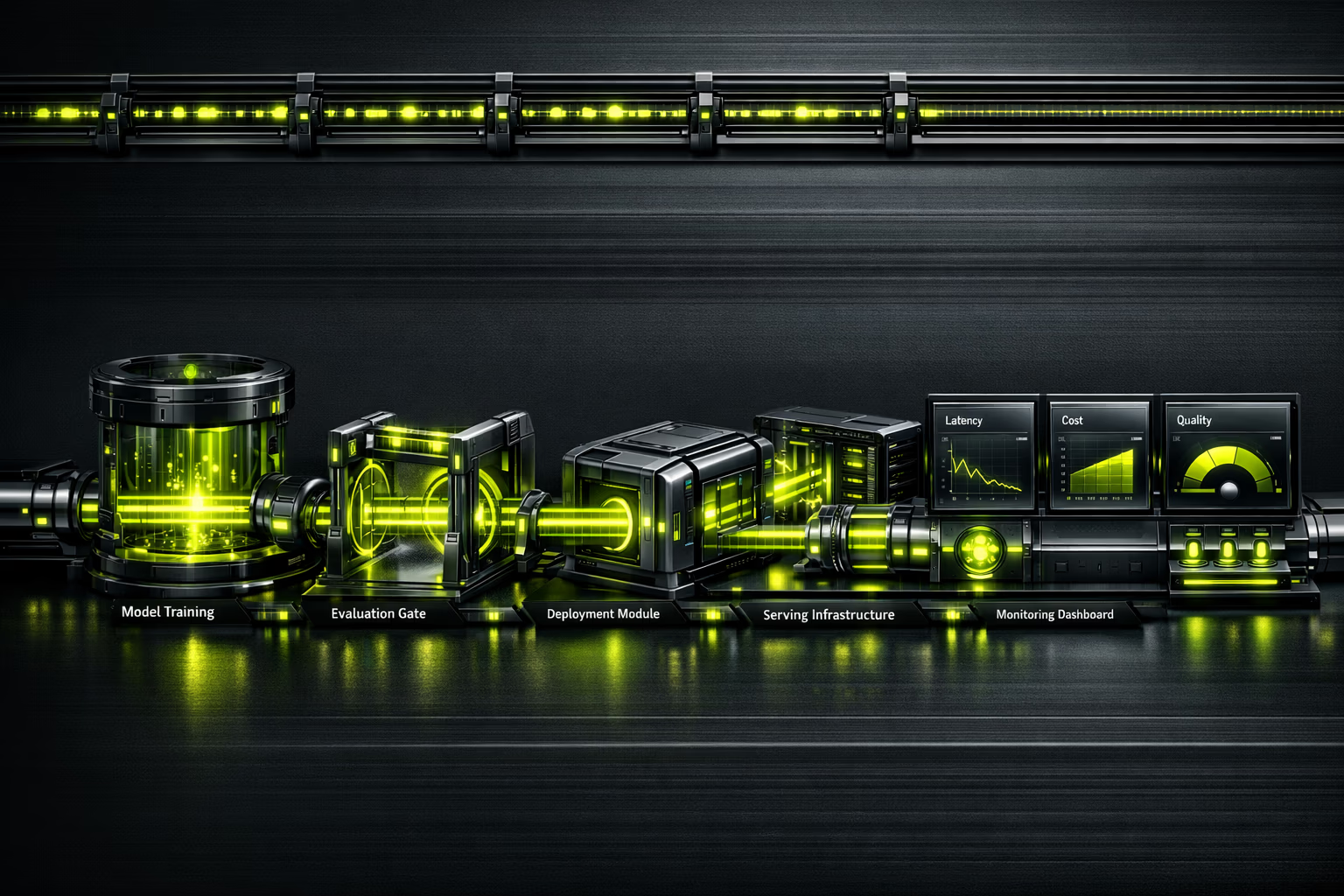

87 % der ML-Projekte erreichen nie die Produktion. LLMOps ist die Disziplin, die diese Lücke schließt: Deployment, Monitoring, Evaluierung und Skalierung von Sprachmodellen mit ingenieurmäßiger Strenge.

Was unser LLMOps-Service umfasst

Alles, was Sie für den zuverlässigen Betrieb von LLMs benötigen.

KI-Observability in Echtzeit

Was Sie nicht messen, können Sie nicht verbessern.

Ein Modell in Produktion ohne Observability ist eine tickende Zeitbombe. LLMOps instrumentiert jeden Aufruf: Latenz p50/p95/p99, verbrauchte Tokens, Kosten pro Request, Antwortqualität mit automatisierten Evaluierungen und Halluzinationserkennung. Einheitliches Dashboard, damit Ihr Team datenbasierte Entscheidungen trifft, nicht intuitionsbasierte.

Executive Summary

Für CEOs und Innovationsverantwortliche.

Der MLOps-Markt wird auf 2,4–4,4 Milliarden USD in 2025 geschätzt, mit einer Prognose von 56–89 Mrd. USD für 2035 (CAGR von 39,8 %). Die Nachfrage nach LLMOps-Fachkräften übersteigt das Angebot bei weitem, was die Zusammenarbeit mit einer spezialisierten Agentur zur effizientesten Entscheidung macht.

87 % der Machine-Learning-Projekte erreichen nie die Produktion. Nicht wegen fehlender Modelle, sondern wegen fehlender Betriebsinfrastruktur. LLMOps verwandelt Prototypen in Geschäftsassets: skalierbar, überwacht und mit kontrollierten Kosten.

In LLMOps zu investieren ist kein Zusatzaufwand; es ist die Absicherung, dass Ihre KI-Investition Rendite erzielt. Ohne Betrieb ist ein Modell, das im Notebook funktioniert, nur ein teures Experiment.

Zusammenfassung für CTO / Tech-Team

Stack, Architektur und technische Entscheidungen.

Model Serving: TrueFoundry oder vLLM für hochperformante Inferenz. Kubernetes (EKS/GKE) für Orchestrierung. GPU-Scheduling mit NVIDIA Triton oder TGI (Text Generation Inference) von Hugging Face. Auto-Scaling basierend auf Queue Depth, nicht auf CPU.

Kontinuierliche Evaluierung: Braintrust oder LangSmith für Eval-Pipelines. Versionierte Referenzdatensätze. Regressionstests vor jedem Deploy. Qualitätsmetriken: Kohärenz, Faktualität, Relevanz, Sicherheit. Human-in-the-Loop-Evaluierung für Edge Cases.

Observability: Traces mit LangSmith/Braintrust, Metriken mit Prometheus/Grafana, strukturierte Logs. Drift-Erkennung mit gleitenden Fenstern. Kosten-Tracking pro Modell, pro Endpoint, pro Kunde. Alerts in PagerDuty/OpsGenie mit automatisierten Runbooks.

Ist es für Sie?

LLMOps setzt voraus, dass Sie bereits Modelle oder KI-Prototypen haben. Wenn Sie noch explorieren, starten Sie mit KI-Beratung.

Für wen

- Unternehmen mit KI-Prototypen, die bereit für die Produktion sind.

- Teams, die bereits LLMs (GPT-4, Claude, Llama) nutzen und skalieren müssen.

- Organisationen mit mehreren Modellen, die den Betrieb vereinheitlichen wollen.

- CTOs, die Observability und Kontrolle über Inferenzkosten benötigen.

- Regulierte Unternehmen, die Audit Logging und Guardrails brauchen (AI Act, DSGVO).

Für wen nicht

- Wenn Sie noch keinen definierten KI-Use-Case haben (beginnen Sie mit Beratung).

- Projekte, die sich mit einer OpenAI-API ohne Anpassung lösen lassen.

- Unternehmen ohne Budget für GPU-Infrastruktur.

- Teams ohne technische Mindestkompetenz für Pipeline-Betrieb.

- Wenn Sie „eine KI suchen, die alles allein macht" — Modelle erfordern Supervision.

LLMOps-Leistungen

Betriebsvertikalen für KI in Produktion.

Modell-Deployment und Serving

Containerisierung von Modellen, Deployment in Kubernetes mit GPU-Scheduling, Auto-Scaling nach Nachfrage. Blue-Green Deployments für Updates ohne Downtime.

Prompt Engineering als Code

Prompts versioniert in Git, evaluiert mit Referenzdatensätzen, deployed mit CI/CD. A/B-Testing von Prompts zur gleichzeitigen Optimierung von Qualität und Kosten.

Evaluierung und Qualitätssicherung

Automatisierte Evaluierungspipelines: Faktualität, Kohärenz, Sicherheit, Halluzinationen. Human-in-the-Loop zur Kalibrierung automatischer Evaluatoren. Qualitätsberichte vor jedem Release.

Observability und Monitoring

End-to-End-Traces für jeden Request. Metriken für Latenz, Durchsatz, Qualität und Kosten. Drift-Erkennung und Leistungsdegradation. Executive- und technische Dashboards.

FinOps für KI

Kosten-Tracking pro Request, pro Modell, pro Kunde. Inferenz-Caching, intelligentes Batching, Modellauswahl nach Kosten/Qualität. Typische Reduktion von 30–60 % der Inferenzkosten.

AgentOps und agentische Systeme

Monitoring von Multi-Step-Agenten: Entscheidungsnachverfolgbarkeit, Werkzeugkontrolle, Circuit Breaker und Timeouts. Die Zukunft von LLMOps ist das Betreiben von Agenten, nicht nur von Modellen.

Implementierungsprozess

Vom Prototyp zur Produktion mit Garantien.

Assessment und Design

Wir bewerten Ihre aktuellen Modelle, Infrastruktur und Produktionsanforderungen. Wir entwerfen die Architektur für Serving, Monitoring und Evaluierung. Wir definieren SLOs (Latenz, Qualität, Verfügbarkeit).

CI/CD-Pipeline für ML

Wir konfigurieren Build-, Test- und Deploy-Pipelines. Prompt Versioning in Git. Kuratierte Eval-Datensätze. Automatisierte Regressionstests mit Qualitätsschwellenwerten.

Deployment und Observability

Modell in Kubernetes mit GPU-Scheduling. Vollständige Instrumentierung: Traces, Metriken, Logs. Dashboards in Grafana. Alerts mit Runbooks konfiguriert.

Guardrails und Optimierung

Sicherheitsfilter, Output-Validierung, Rate Limiting. Kostenoptimierung: Caching, Batching, Right-Sizing. Dokumentation und Wissenstransfer.

Betrieb und kontinuierliche Verbesserung

24/7-Monitoring. Re-Evaluierungszyklen mit Produktionsdaten. A/B-Testing von Modellen und Prompts. Monatliche Leistungs- und Kostenberichte.

Risiken und Minderung

Der Betrieb von LLMs birgt spezifische Risiken. So managen wir sie.

Halluzinationen in Produktion

Guardrails mit Output-Validierung, RAG für Grounding, kontinuierliche Faktualitätsevaluierung. Zielwert: <2 % kritische Halluzinationen.

Unkontrollierte Inferenzkosten

FinOps ab Tag 1: Tracking pro Request, intelligentes Caching, Model Routing (günstiges Modell für einfache Queries, leistungsstarkes für komplexe). Typische Einsparung: 30–60 %.

Schleichende Qualitätsverschlechterung

Eval-Pipelines mit gleitenden Fenstern erkennen Degradation, bevor Nutzer sie melden. Automatischer Rollback bei Unterschreitung des Qualitätsschwellenwerts.

Vendor Lock-in bei einem KI-Anbieter

Abstraktionsschicht ermöglicht den Wechsel zwischen OpenAI, Anthropic und Open-Source-Modellen ohne Neuentwicklung der Anwendung. Regelmäßiger Vergleichstest.

Regulatorische Nichteinhaltung (AI Act)

Audit Logging aller Interaktionen, Inhalts-Guardrails, Dokumentation der Modellentscheidungen. Vorbereitet auf Risikoklassifizierung gemäß AI Act.

Vom Notebook zur Produktion in 6 Wochen

B2C-E-Commerce mit einem KI-Chatbot-Prototyp in einem Jupyter Notebook. 12 Sekunden Latenz pro Antwort, kein Monitoring, unvorhersehbare API-Kosten. Wir implementierten vollständiges LLMOps: Serving in Kubernetes, Caching häufiger Antworten, Model Routing nach Komplexität und Inhalts-Guardrails.

Die LLMOps-Talentlücke

Die Chance der Externalisierung.

Die Nachfrage nach LLMOps/MLOps-Fachkräften übersteigt das Angebot im Verhältnis 5:1. Ein internes KI-Operations-Team aufzubauen erfordert Profile wie ML Engineer, Platform Engineer und SRE — Gehälter, die zusammen +300.000 EUR/Jahr ergeben. Die Zusammenarbeit mit Kiwop gibt Ihnen Zugang zum gleichen Fachwissen ohne Fixkosten und Fluktuationsrisiko.

Häufig gestellte Fragen zu LLMOps

Was Entscheider vor der Investition in KI-Betrieb fragen.

Was ist der Unterschied zwischen MLOps und LLMOps?

MLOps ist die allgemeine Disziplin für Machine-Learning-Betrieb: Trainingspipelines, Serving, Monitoring. LLMOps erweitert MLOps um spezifische Praktiken für Sprachmodelle: Prompt Versioning, nicht-deterministische Qualitätsbewertung, Halluzinationskontrolle und Token-Kostenoptimierung.

Brauche ich LLMOps, wenn ich nur die OpenAI-API nutze?

Ja. Eine API zu nutzen eliminiert nicht den Bedarf an Betrieb: Sie müssen Kosten überwachen, Qualitätsverschlechterung erkennen, Prompts als Code verwalten, Fallbacks bei API-Ausfällen implementieren und Vorschriften einhalten. LLMOps ist umso kritischer, je abhängiger Sie von KI sind.

Was kostet die Inferenz von LLMs in Produktion?

Abhängig von Volumen und Modell. GPT-4o: ~2,50 USD pro Million Eingabe-Tokens. Claude Sonnet: ~3 USD. Open-Source-Modelle (Llama 3): ~0,20 USD mit eigener Infrastruktur. Typische Optimierung reduziert Kosten um 30–60 % durch Caching, Batching und Model Routing.

Was ist „AgentOps"?

AgentOps ist die Weiterentwicklung von LLMOps für agentische Systeme: Modelle, die Werkzeuge nutzen, Multi-Step-Entscheidungen treffen und untereinander kooperieren. Erfordert Entscheidungsnachverfolgbarkeit, Circuit Breaker, Werkzeugkontrolle und Timeouts. Die Zukunft des KI-Betriebs.

Wie bewertet man die Qualität eines LLM in Produktion?

Mit automatisierten Evaluierungspipelines, die messen: Faktualität (sagt es die Wahrheit?), Kohärenz (ergibt es Sinn?), Relevanz (beantwortet es die Frage?) und Sicherheit (erzeugt es schädliche Inhalte?). Ergänzt durch periodische menschliche Evaluierung zur Kalibrierung der automatischen Bewerter.

Wie lange dauert die LLMOps-Implementierung?

Basis-Pipeline (Serving + Monitoring): 4–6 Wochen. Vollständige Pipeline (Eval, Guardrails, FinOps, CI/CD): 8–12 Wochen. Abhängig von Modellkomplexität und bestehender Infrastruktur.

Können wir Open-Source-Modelle statt kommerzieller APIs verwenden?

Absolut. Llama 3, Mistral und Qwen sind für viele Anwendungsfälle tragfähige Alternativen. Der Vorteil: Vorhersagbare Kosten, keine Drittanbieter-Abhängigkeit, Daten auf Ihrer Infrastruktur. Der Trade-off: GPUs und Betriebsexpertise erforderlich. Wir evaluieren die beste Option für jeden Fall.

Wie wirkt sich der europäische AI Act auf den KI-Betrieb aus?

Der AI Act klassifiziert Systeme nach Risiko. Für Hochrisikosysteme: Pflicht-Audit-Logging, technische Dokumentation, Transparenz, menschliche Aufsicht. Gut implementiertes LLMOps erfüllt diese Anforderungen ab Design: vollständige Traces, dokumentierte Guardrails und Logs aller Interaktionen.

Funktionieren Ihre KI-Modelle im Notebook, aber nicht in Produktion?

87 % der ML-Projekte bleiben im Experimentierstadium stecken. Wir bringen Ihre KI in Produktion — mit Observability, Guardrails und kontrollierten Kosten.

Mit einem ML-Engineer sprechen Technisches

Erstaudit.

KI, Sicherheit und Performance. Diagnose mit phasenweisem Vorschlag.

Ihr erstes Meeting ist mit einem Solutions Architect, nicht mit einem Verkäufer.

Diagnose anfordern