LLMOps: lleva tus modelos de IA a producción real

MLflow · LangSmith · Kubernetes · Guardrails

El 87% de los proyectos de ML nunca llegan a producción. LLMOps es la disciplina que cierra esa brecha: despliegue, monitorización, evaluación y escalado de modelos de lenguaje con rigor de ingeniería.

Qué incluye nuestro servicio LLMOps

Todo lo que necesitas para operar LLMs con garantías.

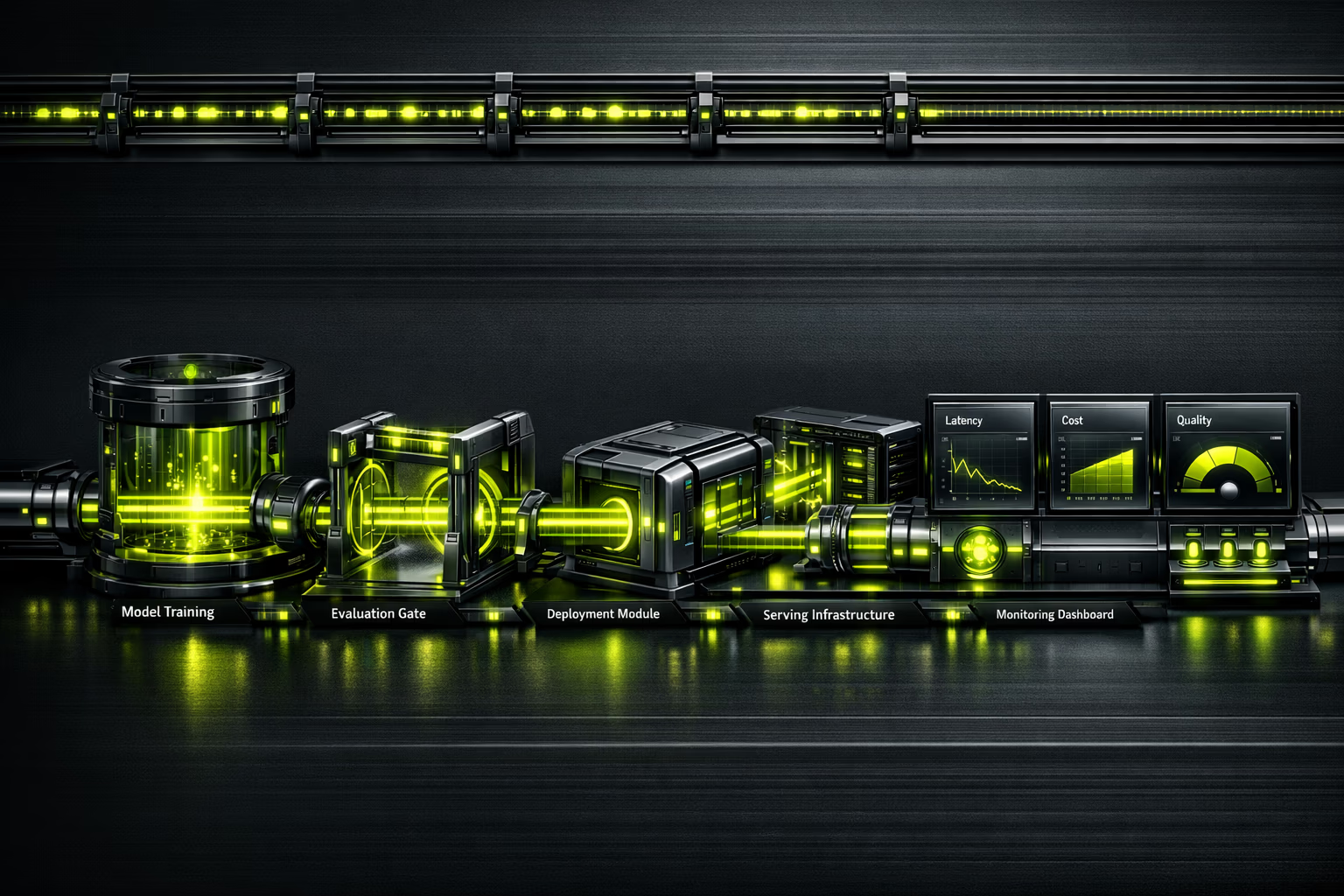

Observabilidad de IA en tiempo real

No puedes mejorar lo que no mides.

Un modelo en producción sin observabilidad es una bomba de relojería. LLMOps instrumenta cada llamada: latencia p50/p95/p99, tokens consumidos, coste por request, calidad de respuesta con evaluaciones automatizadas, y detección de alucinaciones. Dashboard unificado para que tu equipo tome decisiones basadas en datos, no en intuición.

Resumen ejecutivo

Para CEOs y directores de innovación.

El mercado de MLOps se estima en $2.4-4.4 mil millones en 2025, con una proyección de $56-89B para 2035 (CAGR del 39.8%). La demanda de profesionales LLMOps supera ampliamente la oferta, lo que hace que externalizar con una agencia especializada sea la decisión más eficiente.

El 87% de los proyectos de machine learning nunca llegan a producción. No por falta de modelos, sino por falta de infraestructura operativa. LLMOps convierte prototipos en activos de negocio: escalables, monitorizados y con costes controlados.

Invertir en LLMOps no es un coste adicional; es el seguro de que tu inversión en IA genera retorno. Sin operaciones, un modelo que funciona en un notebook es solo un experimento caro.

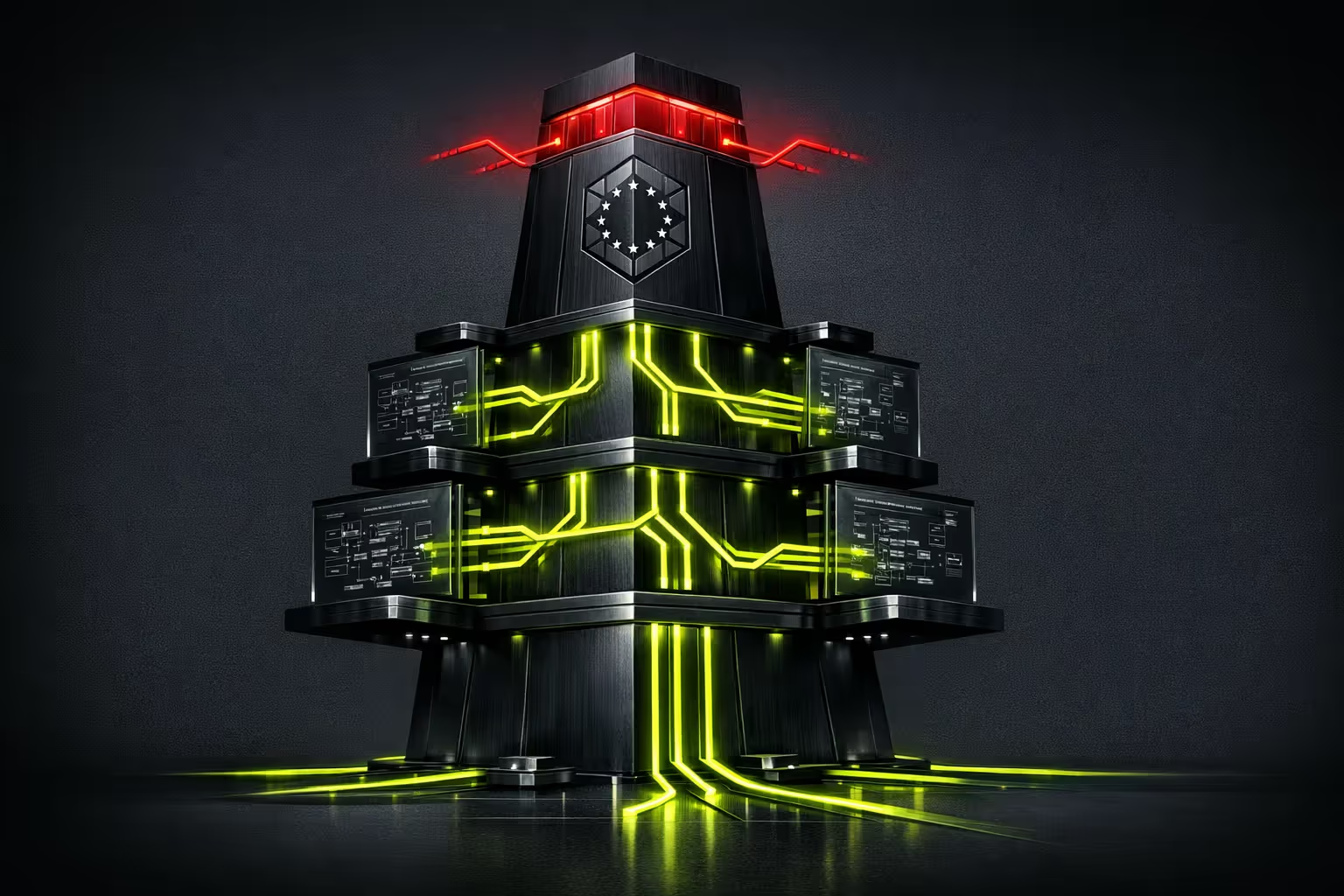

Resumen para CTO / equipo técnico

Stack, arquitectura y decisiones técnicas.

Model serving: TrueFoundry o vLLM para inferencia de alto rendimiento. Kubernetes (EKS/GKE) para orquestación. GPU scheduling con NVIDIA Triton o TGI (Text Generation Inference) de Hugging Face. Autoescalado basado en queue depth, no en CPU.

Evaluación continua: Braintrust o LangSmith para eval pipelines. Datasets de referencia versionados. Tests de regresión antes de cada deploy. Métricas de calidad: coherencia, factualidad, relevancia, seguridad. Evaluación humana-in-the-loop para casos edge.

Observabilidad: Trazas con LangSmith/Braintrust, métricas con Prometheus/Grafana, logs estructurados. Detección de drift con ventanas deslizantes. Cost tracking por modelo, por endpoint, por cliente. Alertas en PagerDuty/OpsGenie con runbooks automatizados.

¿Es para ti?

LLMOps requiere que ya tengas modelos o prototipos de IA. Si aún estás explorando, empieza por consultoría IA.

Para quién

- Empresas con prototipos de IA listos para llevar a producción.

- Equipos que ya usan LLMs (GPT-4, Claude, Llama) y necesitan escalar.

- Organizaciones con múltiples modelos que quieren unificar operaciones.

- CTOs que necesitan observabilidad y control de costes de inferencia.

- Compañías reguladas que requieren audit logging y guardrails (AI Act, RGPD).

Para quién no

- Si aún no tienes un caso de uso definido para IA (empieza por consultoría).

- Proyectos que se resuelven con una API de OpenAI sin personalización.

- Empresas sin presupuesto para infraestructura GPU.

- Equipos sin capacidad técnica mínima para operar pipelines.

- Si buscas "una IA que haga todo sola" — los modelos requieren supervisión.

Servicios LLMOps

Verticales operativas para IA en producción.

Despliegue y serving de modelos

Containerización de modelos, despliegue en Kubernetes con GPU scheduling, autoescalado basado en demanda. Blue-green deployments para actualizaciones sin downtime.

Prompt engineering como código

Prompts versionados en Git, evaluados con datasets de referencia, desplegados con CI/CD. A/B testing de prompts para optimizar calidad y coste simultáneamente.

Evaluación y aseguramiento de calidad

Pipelines de evaluación automatizados: factualidad, coherencia, seguridad, alucinaciones. Human-in-the-loop para calibrar evaluadores automáticos. Reportes de calidad antes de cada release.

Observabilidad y monitorización

Trazas end-to-end de cada request. Métricas de latencia, throughput, calidad y coste. Detección de drift y degradación de rendimiento. Dashboards ejecutivos y técnicos.

FinOps para IA

Tracking de coste por request, por modelo, por cliente. Caching de inferencias, batching inteligente, selección de modelos por coste/calidad. Reducción típica del 30-60% en costes de inferencia.

AgentOps y sistemas agénticos

Monitorización de agentes multi-step: trazabilidad de decisiones, control de herramientas, circuit breakers y timeouts. El futuro de LLMOps es operar agentes, no solo modelos.

Proceso de implementación

De prototipo a producción con garantías.

Assessment y diseño

Evaluamos tus modelos actuales, infraestructura y requisitos de producción. Diseñamos la arquitectura de serving, monitorización y evaluación. Definimos SLOs (latencia, calidad, disponibilidad).

Pipeline de CI/CD para ML

Configuramos pipelines de build, test y deploy. Prompt versioning en Git. Eval datasets curados. Tests de regresión automatizados con umbrales de calidad.

Despliegue y observabilidad

Modelo en Kubernetes con GPU scheduling. Instrumentación completa: trazas, métricas, logs. Dashboards en Grafana. Alertas configuradas con runbooks.

Guardrails y optimización

Filtros de seguridad, validación de outputs, rate limiting. Optimización de costes: caching, batching, right-sizing. Documentación y traspaso de conocimiento.

Operación y mejora continua

Monitorización 24/7. Ciclos de re-evaluación con datos de producción. A/B testing de modelos y prompts. Informes mensuales de rendimiento y costes.

Riesgos y mitigación

Operar LLMs tiene riesgos específicos. Así los gestionamos.

Alucinaciones en producción

Guardrails con validación de outputs, RAG para grounding, evaluación continua de factualidad. Tasa objetivo: <2% alucinaciones críticas.

Costes de inferencia descontrolados

FinOps desde día 1: tracking por request, caching inteligente, model routing (modelo barato para queries simples, potente para complejas). Ahorro típico: 30-60%.

Degradación silenciosa de calidad

Eval pipelines con ventanas deslizantes detectan degradación antes de que los usuarios la reporten. Rollback automático si la calidad cae bajo umbral.

Vendor lock-in con un proveedor de IA

Capa de abstracción que permite cambiar entre OpenAI, Anthropic, modelos open-source sin reescribir aplicación. Evaluación comparativa periódica.

Incumplimiento regulatorio (AI Act)

Audit logging de toda interacción, guardrails de contenido, documentación de decisiones del modelo. Preparados para clasificación de riesgo según AI Act.

De notebook a producción en 6 semanas

E-commerce B2C con un prototipo de chatbot IA en un notebook de Jupyter. Latencia de 12 segundos por respuesta, sin monitorización, costes de API impredecibles. Implementamos LLMOps completo: serving en Kubernetes, caching de respuestas frecuentes, modelo routing por complejidad, y guardrails de contenido.

El gap de talento LLMOps

La oportunidad de externalizar.

La demanda de profesionales de LLMOps/MLOps supera la oferta en un ratio de 5:1. Contratar un equipo interno de operaciones de IA requiere perfiles de ML engineer, platform engineer y SRE — salarios que suman +€300K/año. Externalizar con Kiwop te da acceso al mismo expertise sin el coste fijo ni el riesgo de rotación.

Preguntas frecuentes sobre LLMOps

Lo que los decisores preguntan antes de invertir en operaciones de IA.

¿Qué diferencia hay entre MLOps y LLMOps?

MLOps es la disciplina general de operaciones para machine learning: pipelines de entrenamiento, serving, monitorización. LLMOps extiende MLOps con prácticas específicas para modelos de lenguaje: prompt versioning, evaluación de calidad no determinista, control de alucinaciones, y optimización de costes de tokens.

¿Necesito LLMOps si solo uso la API de OpenAI?

Sí. Usar una API no elimina la necesidad de operaciones: necesitas monitorizar costes, detectar degradación de calidad, gestionar prompts como código, implementar fallbacks cuando la API falla, y cumplir con regulaciones. LLMOps es más crítico cuanto más dependes de IA.

¿Cuánto cuesta la inferencia de LLMs en producción?

Depende del volumen y modelo. GPT-4o: ~$2.5 por millón de tokens de entrada. Claude Sonnet: ~$3. Modelos open-source (Llama 3): ~$0.2 con infraestructura propia. La optimización típica reduce costes un 30-60% con caching, batching y model routing.

¿Qué es "AgentOps"?

AgentOps es la evolución de LLMOps para sistemas agénticos: modelos que usan herramientas, toman decisiones multi-step, y colaboran entre sí. Requiere trazabilidad de decisiones, circuit breakers, control de herramientas, y timeouts. Es el futuro de las operaciones de IA.

¿Cómo se evalúa la calidad de un LLM en producción?

Con pipelines de evaluación automatizados que miden: factualidad (¿dice verdades?), coherencia (¿tiene sentido?), relevancia (¿responde a lo preguntado?), y seguridad (¿genera contenido dañino?). Complementado con evaluación humana periódica para calibrar los evaluadores automáticos.

¿Cuánto tiempo se tarda en implementar LLMOps?

Pipeline básico (serving + monitorización): 4-6 semanas. Pipeline completo (eval, guardrails, FinOps, CI/CD): 8-12 semanas. Depende de la complejidad de los modelos y la infraestructura existente.

¿Podemos usar modelos open-source en vez de APIs comerciales?

Absolutamente. Llama 3, Mistral, Qwen son alternativas viables para muchos casos de uso. La ventaja: coste predecible, sin dependencia de terceros, datos en tu infraestructura. El trade-off: necesitas GPUs y expertise para operar. Evaluamos la mejor opción para cada caso.

¿Cómo afecta el AI Act europeo a las operaciones de IA?

El AI Act clasifica sistemas por riesgo. Para sistemas de alto riesgo: audit logging obligatorio, documentación técnica, transparencia, supervisión humana. LLMOps bien implementado cubre estos requisitos desde diseño: trazas completas, guardrails documentados, y logs de todas las interacciones.

¿Tus modelos IA funcionan en un notebook pero no en producción?

El 87% de los proyectos ML se quedan en experimentación. Llevamos tu IA a producción con observabilidad, guardrails y costes controlados.

Hablar con un ML engineer Auditoría

técnica inicial.

IA, seguridad y rendimiento. Diagnóstico y propuesta cerrada por fases.

Tu primera reunión es con un Arquitecto de Soluciones, no con un comercial.

Solicitar diagnóstico