RAG Empresarial: IA que responde con tus datos reales

Tu empresa tiene miles de documentos, manuales, y bases de datos que nadie consulta eficientemente. RAG (Retrieval-Augmented Generation) conecta tus datos con IA generativa para respuestas precisas, citadas y verificables. Mercado de $1.960M en 2025, proyectado a $40.300M en 2035.

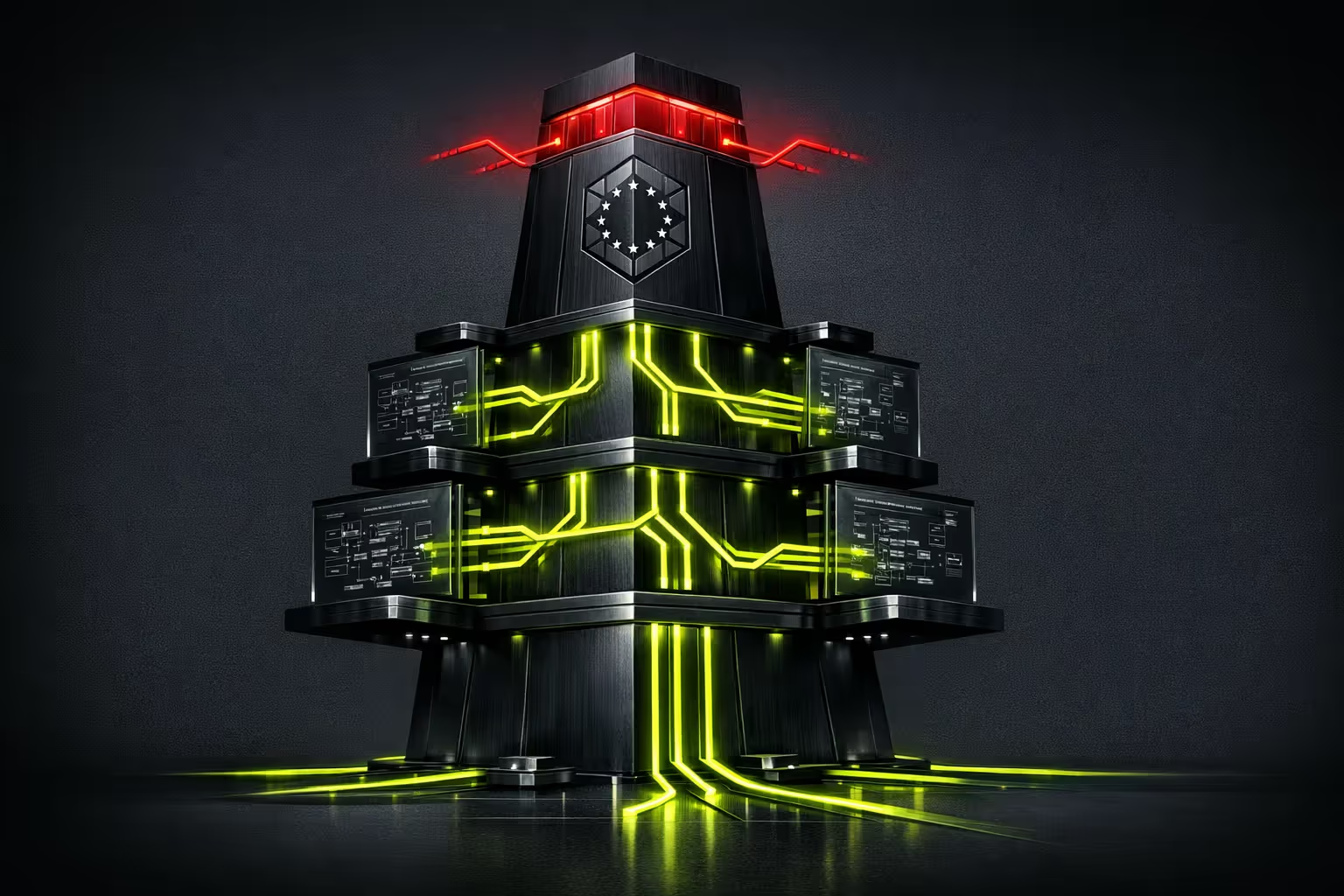

Qué incluye el servicio

Entregables del sistema RAG completo.

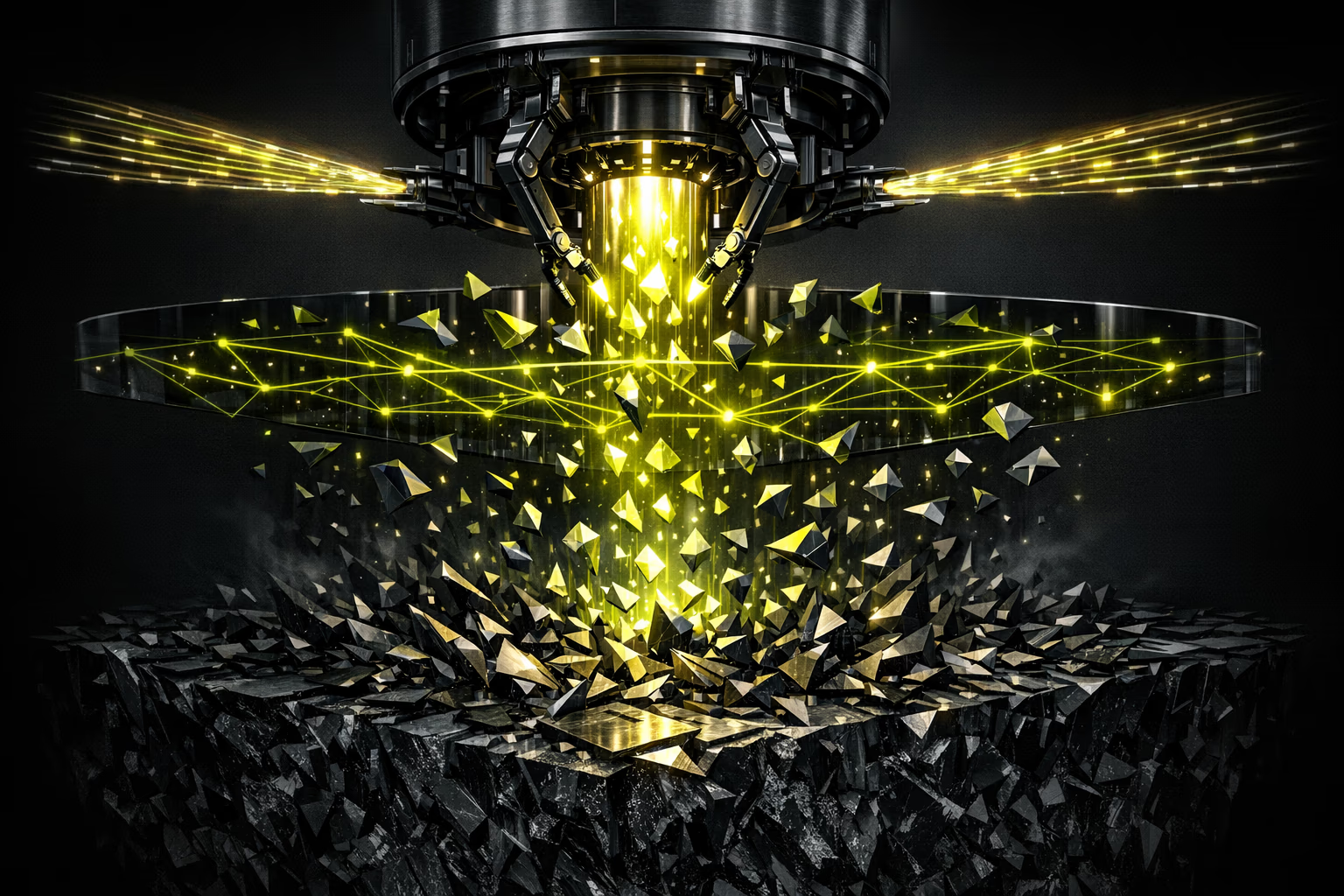

Cómo funciona un sistema RAG

La arquitectura que elimina alucinaciones.

RAG combina lo mejor de dos mundos: la capacidad de lenguaje natural de los LLMs con la precisión de tus datos reales. Cuando un usuario pregunta, el sistema busca información relevante en tu base de conocimiento vectorial, la inyecta en el contexto del LLM, y genera una respuesta fundamentada con citas verificables. El resultado: respuestas que suenan naturales pero están ancladas en datos reales.

Resumen ejecutivo

Para la dirección.

El RAG empresarial convierte tu base de conocimiento dispersa (documentos, manuales, FAQs, bases de datos) en un sistema de IA que responde preguntas con precisión del 95%+ y cita la fuente. El caso de uso más inmediato: soporte al cliente con reducción del 50% en tickets L1.

Inversión típica: 45.000-500.000+ EUR según complejidad y volumen de datos. ROI en 4-8 meses para equipos de soporte de 10+ personas. El riesgo principal (alucinaciones) se mitiga con evaluación continua y human-in-the-loop para decisiones críticas.

Resumen técnico

Para el CTO.

Arquitectura modular: ingesta → chunking → embedding → vectorstore → retrieval → reranking → generation. Cada componente es intercambiable. Embeddings: OpenAI ada-002, Cohere embed-v3, o modelos open-source (BGE, E5). Vectorstores: Pinecone (managed), Qdrant (self-hosted), pgvector (PostgreSQL nativo).

Evaluación con framework RAGAS: faithfulness, answer relevance, context precision, context recall. Pipeline de CI/CD para testing de regresión en precisión. Monitorización de costes por query, latencia P95, y drift de embeddings. Servidores europeos para cumplimiento RGPD.

¿Es para ti?

RAG empresarial tiene sentido cuando tienes datos valiosos que nadie aprovecha.

Para quién

- Empresas con bases de conocimiento extensas (manuales, documentación técnica, FAQs, normativa).

- Equipos de soporte que responden las mismas preguntas repetidamente con información dispersa.

- Organizaciones que necesitan IA con datos propios sin enviar información sensible a modelos públicos.

- Departamentos legales, de compliance o médicos que necesitan respuestas precisas y citadas.

- Empresas que quieren un buscador interno inteligente que entienda lenguaje natural.

Para quién no

- Organizaciones con poca documentación o datos no estructurados de baja calidad.

- Si necesitas IA generativa creativa (campañas, contenido) sin anclar en datos propios.

- Empresas sin presupuesto para mantener y actualizar la base de conocimiento.

- Casos de uso donde una búsqueda por palabras clave tradicional es suficiente.

- Si no tienes datos digitalizados: primero necesitas digitalizar tu conocimiento.

5 casos de uso de RAG empresarial

Dónde RAG genera más impacto.

Soporte al cliente inteligente

Chatbot que responde consultas de clientes consultando tu base de conocimiento en tiempo real. Reduce tickets L1 en un 50%, responde en segundos, y escala a humano cuando la confianza es baja. Con historial de conversación y feedback loop para mejora continua.

Asistente de conocimiento interno

Empleados preguntan en lenguaje natural y obtienen respuestas de documentación interna, políticas, y procedimientos. Reduce un 40% el tiempo buscando información. Especialmente valioso para onboarding de nuevos empleados y equipos distribuidos.

Procesamiento de documentos

Extrae información de contratos, facturas, informes, y documentos legales de forma automática. Clasifica, resume, y responde preguntas sobre miles de documentos en segundos. Ideal para departamentos legales, compliance y financiero.

Buscador semántico empresarial

Sustituye la búsqueda por keywords por búsqueda semántica que entiende intención. "¿Cuál es el proceso para devolver un producto defectuoso?" en vez de buscar "devolución defecto". Conecta con Confluence, SharePoint, Notion, y sistemas internos.

Asistente de ventas con datos de producto

Equipo comercial consulta specs, comparativas, y argumentarios en lenguaje natural. Genera propuestas personalizadas basadas en la ficha técnica real del producto y el historial del cliente. Reducción del 30% en tiempo de preparación de ofertas.

Proceso de implementación

De tus datos en bruto a un sistema RAG en producción.

Auditoría de datos y diseño

Evaluamos tus fuentes de datos (documentos, bases de datos, APIs), definimos la estrategia de chunking y embeddings, y diseñamos la arquitectura RAG. Entregable: documento técnico con pipeline completo.

Ingesta y vectorización

Conectamos fuentes de datos, procesamos documentos, y creamos la base vectorial. Optimización de chunking (tamaño, solapamiento, metadata). Pruebas de retrieval con queries reales de tu negocio.

Orquestación y evaluación

Construimos el pipeline completo: retrieval → reranking → generation con citación. Evaluación con RAGAS (faithfulness, relevance, precision). Ajuste hasta superar umbrales de calidad definidos.

Interfaz, despliegue y monitorización

Frontend (chatbot o buscador), despliegue en producción, y monitorización continua: precisión, latencia, costes, y feedback de usuarios. Soporte post-lanzamiento de 30 días incluido.

Riesgos y mitigación

Transparencia total sobre los desafíos del RAG.

Alucinaciones y respuestas incorrectas

Evaluación continua con RAGAS (faithfulness >0.9). Citación obligatoria de fuentes. Umbrales de confianza: si el sistema no está seguro, lo dice explícitamente en vez de inventar.

Privacidad y datos sensibles

Procesamiento en servidores europeos (RGPD). Opción de despliegue on-premise o cloud privada. Acceso granular por rol: cada usuario ve solo lo que su perfil permite.

Escalabilidad con millones de documentos

Vectorstores diseñados para escalar: Pinecone soporta miles de millones de vectores, Qdrant escala horizontalmente. Indexación incremental para nuevos documentos sin reprocessar todo.

Costes de API y embeddings crecientes

Presupuestos por consulta con alertas. Cache semántico para queries repetidas (-60% costes). Modelos de embedding más eficientes para volúmenes altos. Opción de modelos open-source on-premise para coste fijo.

Experiencia en IA y datos empresariales

Llevamos 15+ años integrando sistemas y datos para empresas europeas. Desde 2023, implementamos soluciones RAG en producción para clientes con bases de conocimiento de miles de documentos. No somos un laboratorio de investigación: construimos sistemas que funcionan en el mundo real con datos reales y cumplimiento RGPD.

Preguntas frecuentes

Lo que nuestros clientes preguntan sobre RAG.

¿Qué es RAG y por qué lo necesita mi empresa?

RAG (Retrieval-Augmented Generation) es una arquitectura que conecta tus datos con IA generativa. En vez de que el LLM "invente" respuestas, busca información relevante en tus documentos y genera respuestas ancladas en datos reales. Tu empresa lo necesita si tiene conocimiento valioso disperso en documentos que nadie consulta eficientemente.

¿Cómo se eliminan las alucinaciones?

Tres capas de protección: 1) Grounding: el LLM solo genera respuestas basadas en documentos recuperados. 2) Citación obligatoria: cada respuesta incluye la fuente y el fragmento exacto. 3) Umbrales de confianza: si la relevancia es baja, el sistema responde "no tengo información suficiente" en vez de inventar.

¿Cuánto cuesta implementar un sistema RAG?

Proyecto básico (1 fuente de datos, chatbot simple): 45.000-80.000 EUR. Proyecto intermedio (múltiples fuentes, buscador semántico, evaluación): 80.000-200.000 EUR. Proyecto enterprise (multi-tenant, on-premise, integraciones complejas): 200.000-500.000+ EUR. Siempre con propuesta detallada y ROI estimado.

¿Cuánto tiempo tarda la implementación?

Un sistema RAG funcional en producción: 6-10 semanas. Incluye auditoría de datos, ingesta, vectorización, pipeline de retrieval, evaluación, interfaz, y despliegue. Proyectos enterprise con múltiples integraciones: 12-16 semanas. Prototipo funcional disponible en la semana 4.

¿Es seguro? ¿Mis datos están protegidos?

Sí. Procesamiento en servidores europeos con cumplimiento RGPD completo. Opciones de despliegue: cloud privada, on-premise, o híbrido. Los datos nunca se usan para entrenar modelos de terceros. Acceso granular por rol y auditoría completa de consultas.

¿Qué formatos de documentos soporta?

Prácticamente todos: PDF, Word, Excel, PowerPoint, HTML, Markdown, Confluence, SharePoint, Notion, Google Docs, bases de datos SQL, APIs REST, y texto plano. Usamos Unstructured.io para procesamiento avanzado de documentos complejos con tablas, imágenes, y layouts irregulares.

¿Se actualiza automáticamente cuando cambian los datos?

Sí. Configuramos ingesta incremental: cuando se añade o modifica un documento, se reprocessa y actualiza en la base vectorial automáticamente. Opciones: webhooks (tiempo real), cron jobs (periódico), o trigger manual. Sin necesidad de reindexar toda la base de datos.

¿Puedo usar RAG con modelos open-source en vez de OpenAI?

Absolutamente. Nuestra arquitectura es agnóstica de modelo. Puedes usar Llama 3, Mistral, Mixtral, o cualquier modelo de HuggingFace desplegado en tu propia infraestructura. Esto elimina dependencia de proveedores y reduce costes por consulta a prácticamente cero (solo infraestructura). Ideal para datos altamente sensibles que no pueden salir de tu red.

¿Cuánto conocimiento pierde tu empresa cada día?

Auditoría gratuita de tu base de conocimiento. Evaluamos tus fuentes de datos, estimamos el impacto de un sistema RAG, y diseñamos la arquitectura. Sin compromiso.

Solicitar auditoría RAG Auditoría

técnica inicial.

IA, seguridad y rendimiento. Diagnóstico y propuesta cerrada por fases.

Tu primera reunión es con un Arquitecto de Soluciones, no con un comercial.

Solicitar diagnóstico