RAG Empresarial: IA que responde com os seus dados reais

A sua empresa tem milhares de documentos, manuais e bases de dados que ninguém consulta eficientemente. RAG (Retrieval-Augmented Generation) conecta os seus dados com IA generativa para respostas precisas, citadas e verificáveis. Mercado de $1.960M em 2025, projetado para $40.300M em 2035.

O que inclui o serviço

Entregáveis do sistema RAG completo.

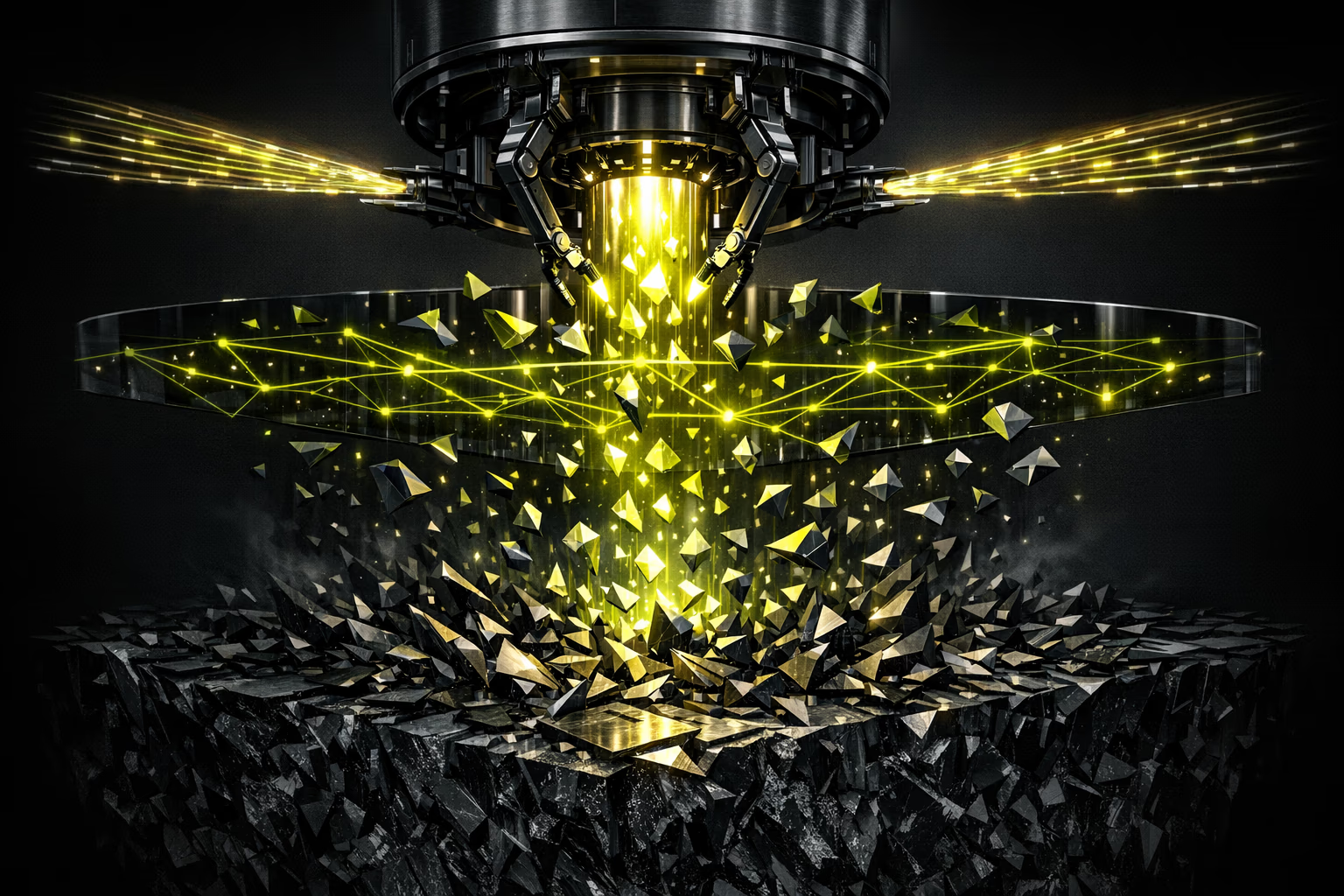

Como funciona um sistema RAG

A arquitetura que elimina alucinações.

O RAG combina o melhor de dois mundos: a capacidade de linguagem natural dos LLMs com a precisão dos seus dados reais. Quando um utilizador pergunta, o sistema pesquisa informação relevante na sua base de conhecimento vetorial, injeta-a no contexto do LLM e gera uma resposta fundamentada com citações verificáveis. O resultado: respostas que soam naturais mas estão ancoradas em dados reais.

Resumo executivo

Para a direção.

O RAG empresarial transforma a sua base de conhecimento dispersa (documentos, manuais, FAQs, bases de dados) num sistema de IA que responde a perguntas com precisão de 95%+ e cita a fonte. O caso de uso mais imediato: suporte ao cliente com redução de 50% em tickets L1.

Investimento típico: 45.000-500.000+ EUR conforme complexidade e volume de dados. ROI em 4-8 meses para equipas de suporte de 10+ pessoas. O risco principal (alucinações) é mitigado com avaliação contínua e human-in-the-loop para decisões críticas.

Resumo técnico

Para o CTO.

Arquitetura modular: ingestão → chunking → embedding → vectorstore → retrieval → reranking → generation. Cada componente é intercambiável. Embeddings: OpenAI ada-002, Cohere embed-v3 ou modelos open-source (BGE, E5). Vectorstores: Pinecone (managed), Qdrant (self-hosted), pgvector (PostgreSQL nativo).

Avaliação com framework RAGAS: faithfulness, answer relevance, context precision, context recall. Pipeline de CI/CD para testing de regressão em precisão. Monitorização de custos por query, latência P95 e drift de embeddings. Servidores europeus para cumprimento do RGPD.

É para si?

O RAG empresarial faz sentido quando tem dados valiosos que ninguém aproveita.

Para quem

- Empresas com bases de conhecimento extensas (manuais, documentação técnica, FAQs, normativa).

- Equipas de suporte que respondem às mesmas perguntas repetidamente com informação dispersa.

- Organizações que necessitam de IA com dados próprios sem enviar informação sensível a modelos públicos.

- Departamentos jurídicos, de compliance ou médicos que precisam de respostas precisas e citadas.

- Empresas que querem um pesquisador interno inteligente que compreenda linguagem natural.

Para quem não

- Organizações com pouca documentação ou dados não estruturados de baixa qualidade.

- Se necessita de IA generativa criativa (campanhas, conteúdo) sem ancorar em dados próprios.

- Empresas sem orçamento para manter e atualizar a base de conhecimento.

- Casos de uso onde uma pesquisa por palavras-chave tradicional é suficiente.

- Se não tem dados digitalizados: primeiro precisa de digitalizar o seu conhecimento.

5 casos de uso de RAG empresarial

Onde o RAG gera mais impacto.

Suporte ao cliente inteligente

Chatbot que responde a consultas de clientes acedendo à sua base de conhecimento em tempo real. Reduz tickets L1 em 50%, responde em segundos e escala para humano quando a confiança é baixa. Com histórico de conversação e feedback loop para melhoria contínua.

Assistente de conhecimento interno

Os colaboradores perguntam em linguagem natural e obtêm respostas de documentação interna, políticas e procedimentos. Reduz 40% do tempo a pesquisar informação. Especialmente valioso para onboarding de novos colaboradores e equipas distribuídas.

Processamento de documentos

Extrai informação de contratos, faturas, relatórios e documentos legais de forma automática. Classifica, resume e responde a perguntas sobre milhares de documentos em segundos. Ideal para departamentos jurídicos, compliance e financeiro.

Pesquisador semântico empresarial

Substitui a pesquisa por keywords por pesquisa semântica que compreende intenção. "Qual é o processo para devolver um produto defeituoso?" em vez de pesquisar "devolução defeito". Conecta com Confluence, SharePoint, Notion e sistemas internos.

Assistente de vendas com dados de produto

A equipa comercial consulta especificações, comparativas e argumentários em linguagem natural. Gera propostas personalizadas baseadas na ficha técnica real do produto e no histórico do cliente. Redução de 30% no tempo de preparação de propostas.

Processo de implementação

Dos seus dados em bruto a um sistema RAG em produção.

Auditoria de dados e desenho

Avaliamos as suas fontes de dados (documentos, bases de dados, APIs), definimos a estratégia de chunking e embeddings e desenhamos a arquitetura RAG. Entregável: documento técnico com pipeline completo.

Ingestão e vetorização

Conectamos fontes de dados, processamos documentos e criamos a base vetorial. Otimização de chunking (tamanho, sobreposição, metadata). Testes de retrieval com queries reais do seu negócio.

Orquestração e avaliação

Construímos o pipeline completo: retrieval → reranking → generation com citação. Avaliação com RAGAS (faithfulness, relevance, precision). Ajuste até superar os limiares de qualidade definidos.

Interface, implementação e monitorização

Frontend (chatbot ou pesquisador), implementação em produção e monitorização contínua: precisão, latência, custos e feedback de utilizadores. Suporte pós-lançamento de 30 dias incluído.

Riscos e mitigação

Transparência total sobre os desafios do RAG.

Alucinações e respostas incorretas

Avaliação contínua com RAGAS (faithfulness >0.9). Citação obrigatória de fontes. Limiares de confiança: se o sistema não tem certeza, di-lo explicitamente em vez de inventar.

Privacidade e dados sensíveis

Processamento em servidores europeus (RGPD). Opção de implementação on-premise ou cloud privada. Acesso granular por papel: cada utilizador vê apenas o que o seu perfil permite.

Escalabilidade com milhões de documentos

Vectorstores desenhados para escalar: Pinecone suporta milhares de milhões de vetores, Qdrant escala horizontalmente. Indexação incremental para novos documentos sem reprocessar tudo.

Custos de API e embeddings crescentes

Orçamentos por consulta com alertas. Cache semântico para queries repetidas (-60% custos). Modelos de embedding mais eficientes para volumes altos. Opção de modelos open-source on-premise para custo fixo.

Experiência em IA e dados empresariais

Levamos mais de 15 anos a integrar sistemas e dados para empresas europeias. Desde 2023, implementamos soluções RAG em produção para clientes com bases de conhecimento de milhares de documentos. Não somos um laboratório de investigação: construímos sistemas que funcionam no mundo real com dados reais e cumprimento do RGPD.

Perguntas frequentes

O que os nossos clientes perguntam sobre RAG.

O que é RAG e por que é que a minha empresa precisa?

RAG (Retrieval-Augmented Generation) é uma arquitetura que conecta os seus dados com IA generativa. Em vez de o LLM "inventar" respostas, pesquisa informação relevante nos seus documentos e gera respostas ancoradas em dados reais. A sua empresa precisa se tem conhecimento valioso disperso em documentos que ninguém consulta eficientemente.

Como se eliminam as alucinações?

Três camadas de proteção: 1) Grounding: o LLM só gera respostas baseadas em documentos recuperados. 2) Citação obrigatória: cada resposta inclui a fonte e o fragmento exato. 3) Limiares de confiança: se a relevância é baixa, o sistema responde "não tenho informação suficiente" em vez de inventar.

Quanto custa implementar um sistema RAG?

Projeto básico (1 fonte de dados, chatbot simples): 45.000-80.000 EUR. Projeto intermédio (múltiplas fontes, pesquisador semântico, avaliação): 80.000-200.000 EUR. Projeto enterprise (multi-tenant, on-premise, integrações complexas): 200.000-500.000+ EUR. Sempre com proposta detalhada e ROI estimado.

Quanto tempo demora a implementação?

Um sistema RAG funcional em produção: 6-10 semanas. Inclui auditoria de dados, ingestão, vetorização, pipeline de retrieval, avaliação, interface e implementação. Projetos enterprise com múltiplas integrações: 12-16 semanas. Protótipo funcional disponível na semana 4.

É seguro? Os meus dados estão protegidos?

Sim. Processamento em servidores europeus com cumprimento total do RGPD. Opções de implementação: cloud privada, on-premise ou híbrido. Os dados nunca são utilizados para treinar modelos de terceiros. Acesso granular por papel e auditoria completa de consultas.

Que formatos de documentos suporta?

Praticamente todos: PDF, Word, Excel, PowerPoint, HTML, Markdown, Confluence, SharePoint, Notion, Google Docs, bases de dados SQL, APIs REST e texto simples. Utilizamos Unstructured.io para processamento avançado de documentos complexos com tabelas, imagens e layouts irregulares.

Atualiza-se automaticamente quando os dados mudam?

Sim. Configuramos ingestão incremental: quando se adiciona ou modifica um documento, é reprocessado e atualizado na base vetorial automaticamente. Opções: webhooks (tempo real), cron jobs (periódico) ou trigger manual. Sem necessidade de reindexar toda a base de dados.

Posso usar RAG com modelos open-source em vez de OpenAI?

Absolutamente. A nossa arquitetura é agnóstica de modelo. Pode utilizar Llama 3, Mistral, Mixtral ou qualquer modelo do HuggingFace implementado na sua própria infraestrutura. Isto elimina dependência de fornecedores e reduz custos por consulta a praticamente zero (apenas infraestrutura). Ideal para dados altamente sensíveis que não podem sair da sua rede.

Quanto conhecimento perde a sua empresa todos os dias?

Auditoria gratuita da sua base de conhecimento. Avaliamos as suas fontes de dados, estimamos o impacto de um sistema RAG e desenhamos a arquitetura. Sem compromisso.

Solicitar auditoria RAG Auditoria

técnica inicial.

IA, segurança e desempenho. Diagnóstico com proposta faseada.

A sua primeira reunião é com um Arquiteto de Soluções, não com um comercial.

Solicitar diagnóstico